Serverløs computing har hurtigt taget fart i løbet af de sidste par år. Især AWS holder samtaler om virksomhedsadoption.

Med lanceringen af Lambda serverløse computerplatform i 2014 har AWS indtaget forsædet i den revolutionerende trendsætning.

Som et resultat oplever den nuværende æra af den moderne netværksindustri en massiv galop. Mønten på “Serverless computing”-teknologien har blomstret fra en knop i et hurtigt tempo.

“Serverløs computing” er en stigende stjerne i cloud computing-industrien. De traditionelle metoder får et paradigmeskifte. Som følge heraf er fordelene mange.

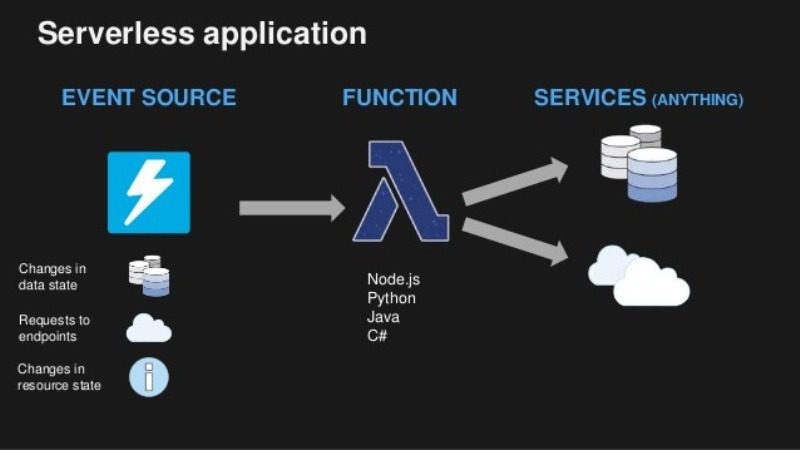

Med andre ord er arkitekturen i Serverless computing designet til en fordel. Her er kodeeksekveringen under fuldstændig kontrol og styret af en cloud-udbyder. Så udviklerens opgave bliver let at udvikle en applikation og implementere den på servere.

Kilde: tonyfendall

Kilde: tonyfendall

For det første, for de mennesker, der foretrækker, at indprente den serverløse computermetode giver arbejdsstyrkeløsninger.

For det andet, dem, der ikke er for, at Serverless er en avanceret teknologi, der er beregnet til at bringe revolution, skal se på de fordele, det giver.

I mellemtiden, hvis du leder efter mere information til forbrug eller i et hvilket som helst dilemma om at investere i serverløs computing, skal du overveje følgende punkter nedenfor.

Indholdsfortegnelse

Avanceret kerne af serverløs arkitektur

Teknologien fungerer med RestAPI’er. Det er nemt at bygge serverløse API’er ved hjælp af rammer. For at få det i gang som udvikler er alt, hvad du skal gøre, at udvikle en applikationsramme, en kode til at pinge backend og et bibliotek til databehandling.

Efterfølgende er den væsentligste fordel, du benytter dig af, “pay as you use”-modellen. Det vil sige, at hele ordningen er omkostningseffektiv, mens din implementering er på rette vej. Den serverløse ramme er praktisk ved integrationen af forskellige udvidelser. Du får mulighed for at bygge et varieret udvalg af apps ved hjælp af kognitiv intelligens, dataanalyse, chatbots.

Edge-udførelse og omkostningseffektivitet

Da flåden af servere er implementeret af den serverløse computerplatform på den primære placering rundt om i verden – bliver din kode eksekveret på kanten, tæt på brugerne. Derfor er responstiden hurtigere, og du betaler for de ressourcer, du bruger.

Du betaler kun for funktionens køretid – varigheden og hyppigheden af kodens eksekvering. Tværtimod, inkluderet i de andre modeller af cloud computing, er det obligatorisk at betale for ledige ressourcer også.

Mange udbydere tilbyder funktioner på kanten, og StackPath er en af dem. Du kan få det startet fra så lavt som $10 om måneden, inklusive 15 millioner anmodningsudførelse.

Function As a Service (FaaS)

Implementeringen af teknologien kommer under “Funktion som en tjeneste (FaaS).”

Her tager cloudleverandøren ansvaret for at starte og stoppe en containers platform. De øvrige aktiviteter omfatter kontrol af infrastruktursikkerhed, skalerbarhed. Det andet pluspunkt her er, at udviklere kan køre enhver applikation/backend-kode uden at klargøre servere.

Hvis vi taler om AWS FaaS, håndterer Lamda al den øvrige funktionalitet, efter at udviklerne har uploadet koden. Det er også muligt med implementeringen af AWS Lambda at udløse automatisk fra enhver AWS-tjenester, web eller mobilapp.

Nanotjenester

I den nuværende æra vælger folk at vælge et logisk domæne: letheden ved at levere nye tjenester i miljøet. Der er minimal ekstra kodningsindsats for at designe en brugbar applikation. Til konteksten kommer betydningen af ”Nanotjenester.” Denne mikroservice er genbrugelig og let at implementere.

Vigtigst er det, at serverløs arkitekturs kompatibilitet med nano-tjenester er utrolig. Det smukke ved nanotjenesterne er, at hver funktionalitet kommer med sit API-endepunkt. Hvert endepunkt peger også på en separat funktionsfil – resultaterne i implementeringen af en CRUD (Opret, Hent, Opdater, Slet).

Frem for alt integreres denne mikroservicefunktionalitet med forretningsløsningen gennem en række små tjenester. Dette klipper godt med serverløs computing. Som et resultat er belastningsbalancering og skalerbarhed forbedret. Du behøver ikke længere at konfigurere klynger og load balancere til servere manuelt.

Event-baseret computeroplevelse

Når du har et højt antal funktionsopkald, er det ligesom at bekymre dig om infrastrukturomkostninger og levering af servere. I sådanne situationer kommer rentable faciliteter fra serverløse udbydere som Microsoft Azure, Google Cloud Functions til undsætning.

Kilde: JetBrains

Kilde: JetBrains

Du kan udløse funktionerne baseret på hændelser som upload billede, brugerens handling, besked tilgængelighed og så videre.

Skalerbarhed

I en traditionel sammenhæng er skalerbarhed besværlig. Du skal udføre en horisontal skalering for nodens størrelse og regnekraft. Lodret skalering er det næste trin i bevarelsen af antallet af arbejdende knudepunkter – en bag- og tårekraft af mand.

Serverløs skalerbarhed

Serverløs skalerbarhed

Med serverløs behøver du ikke bekymre dig om det. Compute-platformen skalerer automatisk infrastrukturen for at køre koden. Du skal finde ud af en passende trigger for at en bestemt begivenhed kan finde sted. Med hver trigger kører koden samtidigt.

Kapacitetsbeslutninger

Ifølge forskning er 30% af de fysiske servere i en komatøs tilstand. Det omtrentlige tal er omkring 11 millioner servere på verdensplan. Hvis du vælger en traditionel serverfunktionalitet, er chancerne for, at du ender blandt disse 30 %. Når du sidder inaktiv i datacentret, kræver serveren din investering for at komme i gang til yderligere brug. Det vil sige, du falder i den tabende ende med denne plan.

På den anden side er planen med serverløs computing, at leverandørerne får en truncheon. Virksomhederne skal ikke længere være afhængige af kapacitetsbeslutningen. De træffer beslutningen og tillader den nødvendige kapacitet ved den rigtige lejlighed baseret på virksomhedens behov – alt i alt et relativt godt investeringsafkast.

Konklusion

Afslutningsvis omfavner udviklere og investorer overalt denne stigende teknologi. Enkelheden i brugsstrukturen gør serverløs computing omkostningseffektiv. Som et resultat er fremtiden her med serverløs computing.

Som en del af integrationsproceduren leverer leverandører API’et til at uploade funktionen med URL’en, som brugeren kan få adgang til. At have stor tillid til dem er afgørende. Bortset fra AWS Lamda og Microsoft Azure er der nogle andre bemærkelsesværdige markedsaktører. Rammerne som Google Cloud Functions, IBM OpenWhisk udgør også den serverløse bølge.

Ser man på det nuværende overgangsmønster, har mange virksomheder forbundet med den serverløse revolutionskampagne. For at opsummere kan du forvente, at denne stigende teknologi vil nå toppen af skyens økosystem.

Du kan også være interesseret i Forståelse af serverløs computing for begyndere.