Leder du efter værktøjer til at forbedre din SEO-rangering, eksponering og konverteringer? For at gøre det skal du bruge et webcrawlerværktøj. En webcrawler er et computerprogram, der scanner internettet. Web-edderkopper, webdataekstraktionssoftware og websteds-skrabeprogrammer er eksempler på internet-webcrawling-teknologier. Det er også kendt som en edderkopbot eller en edderkop. I dag vil vi se på nogle gratis webcrawlerværktøjer til download.

Indholdsfortegnelse

25 bedste gratis webcrawlerværktøjer

Webcrawlerværktøjer giver et væld af oplysninger til data mining og analyse. Dens primære formål er at indeksere websider på internettet. Det kan registrere ødelagte links, duplikeret indhold og manglende sidetitler og identificere alvorlige SEO-problemer. Skrabning af onlinedata kan gavne din virksomhed på en række forskellige måder.

- Adskillige webcrawler-apps kan korrekt crawle data fra enhver websteds-URL.

- Disse programmer hjælper dig med at forbedre strukturen på dit websted, så søgemaskinerne kan forstå det og booste dine placeringer.

På listen over vores topværktøjer har vi samlet en liste over gratis download af webcrawlerværktøj og deres funktioner og omkostninger, som du kan vælge imellem. Listen omfatter også betalingsansøgninger.

1. Åbn Søgeserver

OpenSearchServer er en gratis webcrawler og har en af de bedste vurderinger på internettet. Et af de bedste alternativer, der findes.

- Det er en fuldstændig integreret løsning.

- Open Search Server er en webcrawling og søgemaskine, der er gratis og open source.

- Det er en one-stop og omkostningseffektiv løsning.

- Den kommer med et omfattende sæt søgefunktioner og muligheden for at konstruere din egen indekseringsstrategi.

- Crawlere kan indeksere stort set alt.

- Der er fuldtekst-, boolesk- og fonetiske søgninger at vælge imellem.

- Du kan vælge mellem 17 forskellige sprog.

- Der foretages automatiske klassifikationer.

- Du kan lave en tidsplan for ting, der sker ofte.

2. Spinn3r

Spinn3r webcrawler-programmet giver dig mulighed for fuldt ud at udtrække indhold fra blogs, nyheder, sociale netværkssider, RSS-feeds og ATOM-feeds.

- Den kommer med en lynhurtig API, der håndterer 95 % af indekseringsarbejdet.

- Avanceret spambeskyttelse er inkluderet i denne webcrawling-applikation, som fjerner spam og upassende sprogbrug, hvilket forbedrer datasikkerheden.

- Webskraberen gennemsøger konstant nettet for opdateringer fra adskillige kilder for at præsentere dig for indhold i realtid.

- Det indekserer indhold på samme måde som Google gør, og de udpakkede data gemmes som JSON-filer.

- Parser API giver dig mulighed for hurtigt at parse og administrere information for vilkårlige web-URL’er.

- Firehose API er designet til masseadgang til enorme mængder data.

-

Simple HTTP-headere bruges til at godkende alle Spinn3rs API’er.

- Dette er et webcrawlerværktøj til gratis download.

- Classifier API’en gør det muligt for udviklere at overføre tekst (eller URL’er), der skal mærkes af vores maskinlæringsteknologi.

3. Import.io

Import.io giver dig mulighed for at skrabe millioner af websider på få minutter og konstruere 1000+ API’er baseret på dine behov uden at skrive en enkelt linje kode.

- Den kan nu betjenes programmatisk, og data kan nu hentes automatisk.

- Udtræk data fra mange sider med et tryk på en knap.

- Den kan automatisk genkende paginerede lister, eller du kan klikke på næste side.

- Du kan inkorporere onlinedata i din app eller hjemmeside med kun et par klik.

- Opret alle de webadresser, du har brug for, på et par sekunder ved at bruge mønstre som sidetal og kategorinavne.

- Import.io gør det nemt at demonstrere, hvordan man trækker data fra en side. Du skal blot vælge en kolonne fra dit datasæt og pege på noget på siden, der fanger dit øje.

- Du kan modtage et tilbud på deres hjemmeside.

- Links på listesider fører til detaljerede sider med yderligere information.

- Du kan bruge Import.io til at slutte dig til dem for at hente alle data fra detaljesiderne på én gang.

4. BUBING

BUbiNG, et næste generations webcrawlerværktøj, er kulminationen på forfatternes erfaring med UbiCrawler og ti års forskning i emnet.

- Tusindvis af sider i sekundet kan crawles af en enkelt agent, mens den overholder strenge høflighedsstandarder, både værts- og IP-baserede.

- Dens jobdistribution er bygget på moderne højhastighedsprotokoller for at levere meget høj gennemstrømning, i modsætning til tidligere distribuerede open source-crawlere, der er afhængige af batch-teknikker.

- Den bruger fingeraftrykket fra en strippet side til at opdage næsten dubletter.

- BUbiNG er en fuldstændig distribueret open source Java-crawler.

- Det har mange paralleller.

- Der er mange mennesker, der bruger dette produkt.

- Det er hurtigt.

- Det muliggør kravling i stor skala.

5. GNU Wget

GNU Wget er et gratis webcrawler-værktøj, der kan downloades gratis, og det er et open source-softwareprogram skrevet i C, der giver dig mulighed for at hente filer via HTTP, HTTPS, FTP og FTPS.

- Et af de mest karakteristiske aspekter ved denne applikation er evnen til at oprette NLS-baserede beskedfiler på forskellige sprog.

- Du kan genstarte downloads, der er blevet standset ved at bruge REST og RANGE.

- Det kan også transformere absolutte links i downloadede dokumenter til relative links, hvis det er nødvendigt.

- Brug rekursivt jokertegn i filnavne og spejle mapper.

- Meddelelsesfiler baseret på NLS for en række sprog.

- Under spejling evalueres lokale filtidsstempler for at afgøre, om dokumenter skal downloades igen.

6. Webhose.io

Webhose.io er en fantastisk webcrawler-applikation, der lader dig scanne data og udtrække søgeord på flere sprog ved hjælp af forskellige filtre, der spænder over en bred vifte af kilder.

- Arkivet giver også brugere mulighed for at se tidligere data.

- Derudover er webhose.io’s crawlende dataopdagelser tilgængelige på op til 80 sprog.

- Alle personligt identificerbare oplysninger, der er blevet kompromitteret, kan findes ét sted.

- Undersøg darknets og meddelelsesapplikationer for cybertrusler.

-

XML-, JSON- og RSS-formater er også tilgængelige for skrabet data.

- Du kan modtage et tilbud på deres hjemmeside.

- Brugere kan blot indeksere og søge i de strukturerede data på Webhose.io.

- På alle sprog kan den overvåge og analysere medier.

- Det er muligt at følge diskussioner på opslagstavler og fora.

- Det giver dig mulighed for at holde styr på vigtige blogindlæg fra hele nettet.

7. Norconex

Norconex er en fremragende ressource for virksomheder, der leder efter en open source webcrawler-app.

- Denne samler med alle funktioner kan bruges eller integreres i dit program.

- Det kan også tage en sides fremhævede billede.

- Norconex giver dig mulighed for at crawle ethvert websteds indhold.

- Det er muligt at bruge et hvilket som helst operativsystem.

- Denne webcrawler-software kan crawle millioner af sider på en enkelt server med gennemsnitlig kapacitet.

- Det inkluderer også et sæt værktøjer til at ændre indhold og metadata.

- Få metadata for de dokumenter, du arbejder på i øjeblikket.

-

JavaScript-gengivede sider understøttes.

- Det muliggør registrering af flere sprog.

- Det muliggør oversættelseshjælp.

- Den hastighed, du kravler med, kan ændres.

- Dokumenter, der er blevet ændret eller fjernet, identificeres.

- Dette er et helt gratis webcrawler-program.

8. Dexi.io

Dexi.io er en browserbaseret webcrawler-app, der giver dig mulighed for at skrabe information fra enhver hjemmeside.

-

Udtrækkere, crawlere og rør er de tre typer robotter, du kan bruge til at lave en skrabeoperation.

- Markedsudviklingen forudsiges ved hjælp af Delta-rapporter.

- Dine indsamlede data vil blive opbevaret i to uger på Dexi.ios servere før arkivering, eller du kan straks eksportere de udpakkede data som JSON- eller CSV-filer.

- Du kan modtage et tilbud på deres hjemmeside.

- Der tilbydes professionelle ydelser, såsom kvalitetssikring og løbende vedligeholdelse.

- Det tilbyder kommercielle tjenester, der hjælper dig med at opfylde dine databehov i realtid.

- Det er muligt at spore lager og priser for et ubegrænset antal SKU’er/produkter.

- Det giver dig mulighed for at integrere dataene ved hjælp af live dashboards og fuld produktanalyse.

- Det hjælper dig med at forberede og skylle webbaserede organiserede og brugsklare produktdata.

9. Zyte

Zyte er et cloud-baseret dataudtræksværktøj, der hjælper titusindvis af udviklere med at finde afgørende information. Det er også en af de bedste gratis webcrawler-apps.

- Brugere kan skrabe websider ved hjælp af dens open source visuelle skrabeapplikation uden at kende nogen kodning.

-

Crawlera, en kompleks proxy-rotator, der bruges af Zyte, giver brugerne mulighed for nemt at crawle store eller bot-beskyttede websteder, mens de undgår bot modforanstaltninger.

- Dine onlineoplysninger leveres til tiden og konsekvent. I stedet for at administrere proxyer kan du derfor fokusere på at indhente data.

- På grund af smarte browserfunktioner og gengivelse kan antibots, der er målrettet mod browserlaget, nu nemt administreres.

- På deres hjemmeside kan du muligvis få et tilbud.

- Brugere kan crawle fra adskillige IP’er og regioner ved hjælp af en simpel HTTP API, hvilket eliminerer behovet for proxyvedligeholdelse.

- Det hjælper dig med at generere kontanter, samtidig med at du sparer tid ved at indhente de oplysninger, du har brug for.

- Det giver dig mulighed for at udtrække webdata i stor skala, mens du sparer tid på kodning og vedligeholdelse af spider.

10. Apache Nutch

Apache Nutch er uden tvivl øverst på listen for den bedste open source webcrawler-app.

- Den kan fungere på en enkelt maskine. Den klarer sig dog bedst på en Hadoop-klynge.

- Til autentificering anvendes NTLM-protokollen.

- Det har et distribueret filsystem (via Hadoop).

- Det er et velkendt open source online dataekstraktionssoftwareprojekt, der kan tilpasses og skaleres til data mining.

- Mange dataanalytikere bruger det, videnskabsmænd, applikationsudviklere og webtekstminespecialister over hele verden.

- Det er en Java-baseret løsning på tværs af platforme.

- Som standard udføres hentning og parsing uafhængigt.

- Dataene kortlægges ved hjælp af XPath og navneområder.

- Den indeholder en linkgrafdatabase.

11. VisualScraper

VisualScraper er en anden fantastisk ikke-kodende webskraber til at udtrække data fra internettet.

- Det tilbyder en enkel peg-og-klik brugergrænseflade.

- Det tilbyder også online skrabetjenester såsom dataformidling og bygning af softwareudtrækkere.

- Det holder også øje med dine konkurrenter.

- Brugere kan planlægge deres projekter til at køre på et bestemt tidspunkt eller få sekvensen gentaget hvert minut, dag, uge, måned og år med Visual Scraper.

- Det er billigere og mere effektivt.

- Der er ikke engang en kode at tale.

- Dette er et helt gratis webcrawler-program.

- Realtidsdata kan udtrækkes fra flere websider og gemmes som CSV-, XML-, JSON- eller SQL-filer.

- Brugere kan bruge det til regelmæssigt at udtrække nyheder, opdateringer og forumindlæg.

- Data er 100 % nøjagtige og tilpassede.

12. WebSphinx

WebSphinx er en fantastisk personlig gratis webcrawler-app, der er enkel at konfigurere og bruge.

- Det er designet til sofistikerede webbrugere og Java-programmører, der ønsker at scanne en begrænset del af internettet automatisk.

- Denne online dataekstraktionsløsning inkluderer et Java-klassebibliotek og et interaktivt programmeringsmiljø.

- Sider kan sammenkædes for at lave et enkelt dokument, der kan gennemses eller udskrives.

-

Udtræk al tekst, der passer til et givet mønster, fra en sekvens af sider.

- Webcrawlere kan nu skrives i Java takket være denne pakke.

- Crawler Workbench og WebSPHINX klassebibliotek er begge inkluderet i WebSphinx.

- Crawler Workbench er en grafisk brugergrænseflade, der giver dig mulighed for at tilpasse og betjene en webcrawler.

- En graf kan laves fra en gruppe af websider.

- Gem sider på dit lokale drev til offline læsning.

13. OutWit Hub

OutWit Hub-platformen består af en kerne med et omfattende bibliotek af datagenkendelses- og udtræksfunktioner, hvorpå der kan oprettes et uendeligt antal forskellige apps, som hver bruger kernens funktioner.

- Denne webcrawler-applikation kan scanne gennem websteder og bevare de data, den opdager på en tilgængelig måde.

- Det er en multifunktionshøster med så mange funktioner som muligt for at imødekomme forskellige krav.

- Hub har eksisteret i lang tid.

- Det har udviklet sig til en nyttig og forskelligartet platform for ikke-tekniske brugere og it-professionelle, der ved, hvordan man koder, men erkender, at PHP ikke altid er den ideelle mulighed for at udtrække data.

- OutWit Hub giver en enkelt grænseflade til at skrabe beskedne eller enorme mængder data afhængigt af dine krav.

- Det giver dig mulighed for at skrabe enhver webside direkte fra browseren og konstruere automatiserede agenter, der fanger data og forbereder dem i overensstemmelse med dine krav.

- Du kan modtage et tilbud på deres hjemmeside.

14. Skrabe

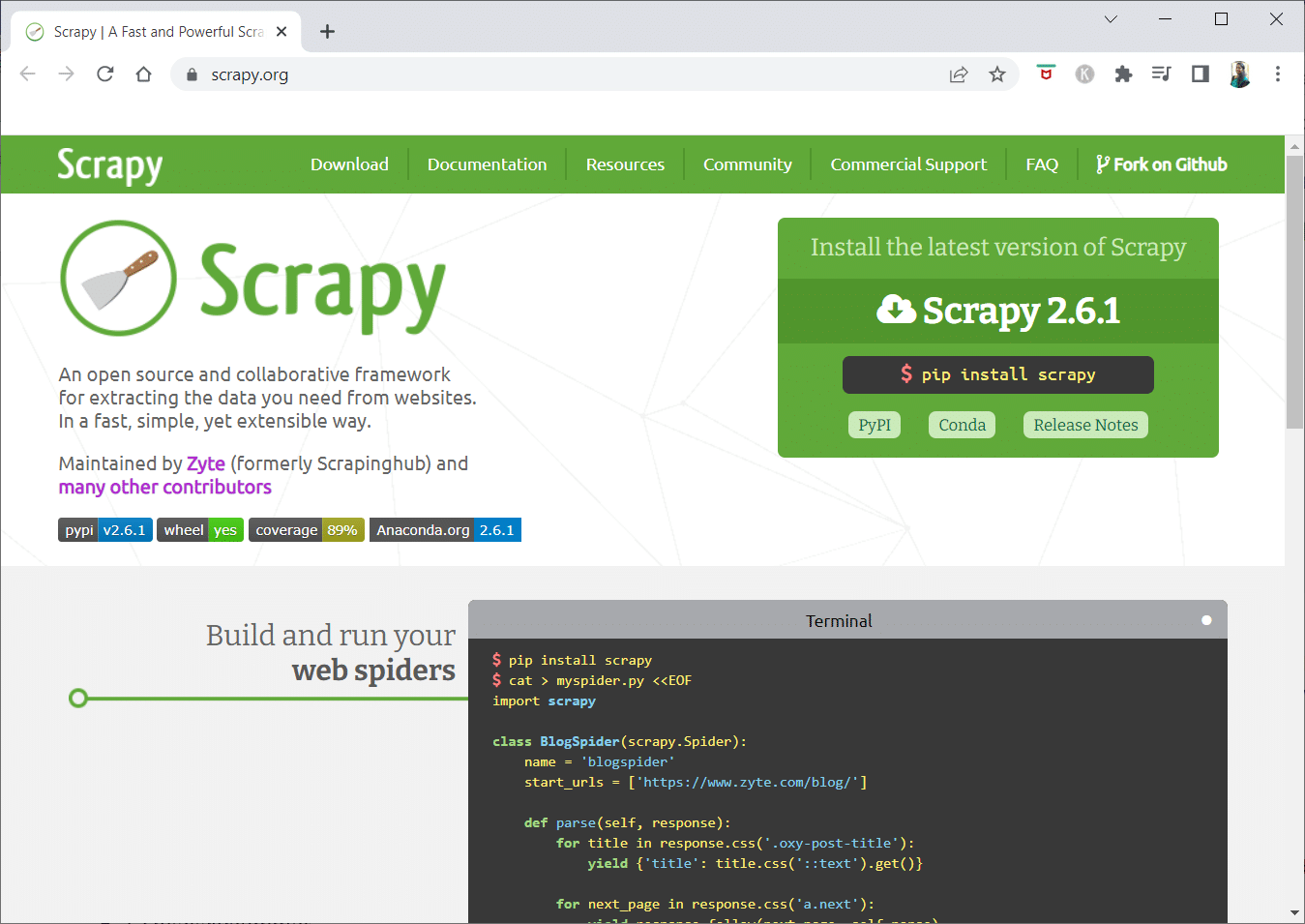

Scrapy er en Python-online-skraberamme til opbygning af skalerbare webcrawlere.

- Det er en komplet webcrawling-ramme, der håndterer alle de egenskaber, der gør webcrawlere svære at oprette, såsom proxy-middleware og forespørgselsspørgsmål.

- Du kan skrive reglerne for udtræk af data og derefter lade Scrapy klare resten.

- Det er nemt at tilføje nye funktioner uden at ændre kernen, fordi den er designet på den måde.

- Det er et Python-baseret program, der fungerer på Linux, Windows, Mac OS X og BSD-systemer.

- Dette er et helt gratis hjælpeprogram.

- Dets bibliotek giver programmører en klar-til-brug struktur til at tilpasse en webcrawler og udtrække data fra internettet i stor skala.

15. Mozenda

Mozenda er også den bedste gratis webcrawler-app. Det er et forretningsorienteret cloud-baseret selvbetjent web-skrabeprogram. Mozenda har over 7 milliarder sider skrabet og har virksomhedskunder over hele verden.

- Mozendas web-skrabeteknologi fjerner kravet om scripts og ansættelse af ingeniører.

- Det fremskynder dataindsamlingen med fem gange.

- Du kan skrabe tekst, filer, billeder og PDF-oplysninger fra websteder med Mozendas peg-og-klik-funktion.

- Ved at organisere datafiler kan du forberede dem til udgivelse.

- Du kan eksportere direkte til TSV, CSV, XML, XLSX eller JSON ved hjælp af Mozeda’s API.

- Du kan bruge Mozendas sofistikerede datastrid til at organisere dine oplysninger, så du kan træffe vitale beslutninger.

- Du kan bruge en af Mozendas partneres platforme til at integrere data eller etablere tilpassede dataintegrationer i nogle få platforme.

16. Cyotek Webcopy

Cyotek Webcopy er et gratis webcrawlerværktøj, der giver dig mulighed for automatisk at downloade et websteds indhold til din lokale enhed.

- Indholdet på den valgte hjemmeside vil blive scannet og downloadet.

- Du kan vælge, hvilke dele af et websted, der skal klones, og hvordan du bruger dets komplekse struktur.

- Den nye lokale rute vil omdirigere links til webstedsressourcer som stylesheets, billeder og andre sider.

- Det vil se på et websteds HTML-markering og forsøge at finde eventuelle forbundne ressourcer, såsom andre websteder, fotos, videoer, fildownloads og så videre.

- Det kan crawle et websted og downloade, hvad det ser for at lave en acceptabel kopi af originalen.

17. Almindelig Kravl

Common Crawl var beregnet til enhver, der er interesseret i at udforske og analysere data for at opnå nyttig indsigt.

- Det er en 501(c)(3) non-profit, der er afhængig af donationer for at drive sine aktiviteter korrekt.

- Enhver, der ønsker at bruge Common Crawl, kan gøre det uden at bruge penge eller forårsage problemer.

- Common Crawl er et korpus, der kan bruges til undervisning, forskning og analyse.

- Du bør læse artiklerne, hvis du ikke har nogen tekniske færdigheder til at lære om de bemærkelsesværdige opdagelser, andre har gjort ved at bruge Common Crawl-data.

- Lærere kan bruge disse værktøjer til at undervise i dataanalyse.

18. Semrush

Semrush er en website-crawler-app, der undersøger siderne og strukturen på din hjemmeside for tekniske SEO-problemer. Løsning af disse problemer kan hjælpe dig med at forbedre dine søgeresultater.

- Det har værktøjer til SEO, markedsundersøgelser, markedsføring på sociale medier og annoncering.

- Den har en brugervenlig brugergrænseflade.

-

Metadata, HTTP/HTTPS, direktiver, statuskoder, duplikeret indhold, sidesvarhastighed, interne links, billedstørrelser, strukturerede data og andre elementer vil blive undersøgt.

- Det giver dig mulighed for at revidere dit websted hurtigt og enkelt.

- Det hjælper med at analysere logfiler.

- Dette program giver et dashboard, der giver dig mulighed for nemt at se webstedsproblemer.

19. Sitechecker.pro

Sitechecker.pro er en anden bedste gratis webcrawler-app. Det er et SEO-tjek til websteder, der hjælper dig med at forbedre dine SEO-placeringer.

- Du kan nemt visualisere strukturen af en webside.

- Det opretter en SEO-revisionsrapport på siden, som kunder kan få via e-mail.

- Dette webcrawler-værktøj kan se på dit websteds interne og eksterne links.

- Det hjælper dig med at bestemme din hjemmesides hastighed.

- Du kan også bruge Sitechecker.pro til at tjekke for indekseringsproblemer på landingssider.

- Det hjælper dig med at forsvare dig mod hackerangreb.

20. Webharvy

Webharvy er et web-skrabeværktøj med en enkel peg-og-klik-grænseflade. Det er designet til dem, der ikke ved, hvordan man koder.

- Prisen for en licens starter ved $139.

- Du vil bruge WebHarvys indbyggede browser til at indlæse onlinesider og vælge de data, der skal skrabes ved hjælp af museklik.

- Det kan automatisk skrabe tekst, fotos, URL’er og e-mails fra websteder og gemme dem i forskellige formater.

-

Proxyservere eller en VPN kan bruges til at få adgang til målwebsteder.

- Skrabning af data kræver ikke oprettelse af nogen programmering eller apps.

- Du kan skrabe anonymt og forhindre web-skrabesoftware i at blive forbudt af webservere ved at bruge proxyservere eller VPN’er til at få adgang til målwebsteder.

- WebHarvy identificerer automatisk datamønstre på websteder.

- Hvis du har brug for at skrabe en liste over objekter fra en webside, behøver du ikke gøre andet.

21. NetSpeak Spider

NetSpeak Spider er en desktop-webcrawler-app til daglige SEO-revisioner, der hurtigt identificerer problemer, udfører systematiske analyser og skraber websider.

- Denne webcrawling-applikation udmærker sig ved at evaluere store websider og samtidig minimere RAM-brug.

- CSV-filer kan let importeres og eksporteres fra webcrawlingsdata.

- Med blot et par klik kan du identificere disse og hundredvis af alvorlige andre SEO-problemer for websteder.

- Værktøjet hjælper dig med at vurdere en hjemmesides on-page optimering, herunder statuskoden, crawl- og indekseringsinstruktioner, hjemmesidens struktur og omdirigeringer, blandt andet.

- Data fra Google Analytics og Yandex kan eksporteres.

- Tag datainterval, enhedstype og segmentering i betragtning for dine webstedssider, trafik, konverteringer, mål og endda e-handelsindstillinger.

- Dets månedlige abonnementer begynder ved $21.

-

Ødelagte links og fotos vil blive opdaget af SEO-crawleren, ligesom duplikeret materiale såsom sider, tekster, dublerede titel- og metabeskrivelses-tags og H1’er.

22. UiPath

UiPath er et webcrawler online skrabeværktøj, der giver dig mulighed for at automatisere robotprocedurer. Det automatiserer online- og desktopdatacrawling for de fleste tredjepartsprogrammer.

- Du kan installere robotprocesautomatiseringsapplikationen på Windows.

- Det kan udtrække data i tabelform og mønsterbaserede former fra mange websider.

- UiPath kan udføre yderligere gennemgange lige ud af boksen.

- Rapportering holder styr på dine robotter, så du til enhver tid kan henvise til dokumentationen.

- Dine resultater vil være mere effektive og succesrige, hvis du standardiserer din praksis.

-

Månedlige abonnementer starter ved $420.

- Markedspladsens mere end 200 færdige komponenter giver dit team mere tid på kortere tid.

- UiPath-robotter øger compliance ved at følge den nøjagtige metode, der opfylder dine behov.

- Virksomheder kan opnå hurtig digital transformation til lavere omkostninger ved at optimere processer, anerkende økonomier og tilbyde indsigt.

23. Heliumskraber

Helium Scraper er en visuel online-datawebcrawling-applikation, der fungerer bedst, når der er ringe sammenhæng mellem elementer. På et grundlæggende niveau kunne det opfylde brugernes krav om gennemgang.

- Det kræver ikke nogen kodning eller konfiguration.

- En klar og nem brugergrænseflade giver dig mulighed for at vælge og tilføje aktiviteter fra en specificeret liste.

- Online-skabeloner er også tilgængelige for specielle krav om gennemgang.

- Uden for skærmen bruges flere Chromium-webbrowsere.

- Øg antallet af samtidige browsere for at få så mange data som muligt.

- Definer dine egne handlinger eller brug tilpasset JavaScript til mere komplekse tilfælde.

- Det kan installeres på en personlig computer eller en dedikeret Windows-server.

- Dens licenser starter ved $99 og stiger derfra.

24. 80Ben

I 2009 blev 80Legs grundlagt for at gøre onlinedata mere tilgængelig. Det er endnu et af de bedste gratis webcrawlerværktøjer. Oprindeligt fokuserede firmaet på at levere webcrawl-tjenester til forskellige kunder.

- Vores omfattende webcrawler-app vil give dig personlig information.

- Crawlhastigheden justeres automatisk baseret på webstedstrafikken.

- Du kan downloade resultater til dit lokale miljø eller computer via 80legs.

- Ved blot at angive en URL kan du crawle webstedet.

- Dets månedlige abonnementer starter ved $29 pr. måned.

- Gennem SaaS er det muligt at konstruere og udføre webcrawl.

- Det har mange servere, der lader dig se webstedet fra forskellige IP-adresser.

- Få øjeblikkelig adgang til webstedsdata i stedet for at gennemsøge nettet.

- Det letter konstruktionen og udførelsen af tilpassede webcrawl.

- Du kan bruge denne applikation til at holde styr på onlinetendenser.

- Du kan lave dine skabeloner, hvis du vil.

25. ParseHub

ParseHub er en fremragende webcrawler-app, der kan indsamle oplysninger fra websteder, der bruger AJAX, JavaScript, cookies og andre relaterede teknologier.

- Dens maskinlæringsmotor kan læse, evaluere og konvertere onlineindhold til meningsfulde data.

- Du kan også gøre brug af den indbyggede web-app i din browser.

- Det er muligt at få oplysninger fra millioner af websteder.

- ParseHub vil automatisk søge gennem tusindvis af links og ord.

- Data indsamles og lagres automatisk på vores servere.

-

Månedlige pakker starter ved $149.

- Som shareware kan du kun bygge fem offentlige projekter på ParseHub.

- Du kan bruge det til at få adgang til rullemenuer, logge på websteder, klikke på kort og administrere websider ved hjælp af uendelig rulning, faner og pop-ups.

- ParseHubs desktop-klient er tilgængelig til Windows, Mac OS X og Linux.

- Du kan erhverve dine skrabet data i ethvert format til analyse.

- Du kan etablere mindst 20 private skrabeprojekter med premium medlemsniveauer.

***

Vi håber, at denne artikel var nyttig, og at du har valgt dit foretrukne gratis webcrawlerværktøj. Del dine tanker, spørgsmål og forslag i kommentarfeltet nedenfor. Du kan også foreslå os de manglende værktøjer. Fortæl os, hvad du vil lære næste gang.