SEO-logfilanalyse hjælper med at forstå crawlerens adfærd på hjemmesiden og identificere potentielle tekniske SEO-optimeringsmuligheder.

SEO uden at analysere crawlernes adfærd er som at flyve i blinde. Du har muligvis indsendt webstedet på Googles søgekonsol og indekseret det, men uden at studere logfilerne, får du ikke en idé om, om dit websted bliver crawlet eller læst af søgemaskinebots korrekt eller ej.

Derfor har jeg samlet alt, hvad du behøver at vide for at analysere SEO-logfiler og identificere problemer og SEO-muligheder fra dem.

Indholdsfortegnelse

Hvad er logfilanalyse?

Analyse af SEO-logfiler er en proces til at genkende mønsteret af søgemaskinebots’ interaktion med webstedet. Logfilanalyse er en del af teknisk SEO.

Revision af logfiler er vigtig for SEO’er for at genkende og løse problemerne i forbindelse med gennemgang, indeksering og statuskoder.

Hvad er logfiler?

Logfiler sporer, hvem der besøger et websted, og hvilket indhold de ser. De indeholder oplysninger om, hvem der har anmodet om adgang til hjemmesiden (også kendt som ‘kunden’).

Den opfattede information kan relateres til søgemaskinebots som Google eller Bing eller en besøgende på webstedet. Typisk indsamles og vedligeholdes logfilregistreringer af webstedets webserver, og de opbevares normalt i et vist tidsrum.

Hvad indeholder logfilen?

Før du kender vigtigheden af logfiler for SEO, er det vigtigt at vide, hvad der er inde i denne fil. Logfilen e indeholder følgende datapunkter:-

- Side-URL, som den besøgende på webstedet anmoder om

- Sidens HTTP-statuskode

- Anmodet server IP-adresse

- Dato og tidspunkt for hit

- Data fra brugeragenten (søgemaskinebot), der foretager en anmodning

- Anmodningsmetode (GET/POST)

Logfiler kan virke komplicerede for dig, hvis du ser på dem først. Alligevel, når du kender formålet og vigtigheden af logfiler til SEO, vil du bruge dem effektivt til at generere værdifuld SEO-indsigt.

Formål med logfilanalyse til SEO

Logfilanalyse hjælper med at løse nogle af de vigtige tekniske SEO-problemer, som giver dig mulighed for at skabe en effektiv SEO-strategi for at optimere hjemmesiden.

Her er nogle SEO-problemer, som kan analyseres ved hjælp af logfiler:

#1. Hyppighed af Googlebots crawl af webstedet

Søgemaskine-bots eller crawlere bør crawle dine vigtige sider ofte, så søgemaskinen kender til din hjemmesideopdateringer eller nyt indhold.

Dine vigtige produkt- eller informationssider bør alle vises i Googles logfiler. En produktside for et produkt, som du ikke længere sælger, samt fraværet af nogen af dine vigtigste kategorisider, er indikatorer på et problem, der kan genkendes ved hjælp af logfiler.

Hvordan bruger en søgemaskinebot crawl-budgettet?

Hver gang en søgemaskinecrawler besøger dit websted, har den et begrænset “crawl-budget”. Google definerer et crawl-budget som summen af et websteds crawl-hastighed og crawl-efterspørgsel.

Gennemgang og indeksering af et websted kan blive hæmmet, hvis det har mange webadresser med lav værdi eller URL’er, der ikke er korrekt indsendt i sitemappet. Gennemgang og indeksering af nøglesider er nemmere, hvis dit crawl-budget er optimeret.

Logfilanalyse hjælper med at optimere crawl-budgettet, der accelererer SEO-indsatsen.

#2. Mobile-first indekseringsproblemer og status

Mobile-first indeksering er nu vigtig for alle websteder, og Google foretrækker det. Logfilanalyse vil fortælle dig, hvor ofte smartphone Googlebot crawler dit websted.

Denne analyse hjælper webmastere med at optimere websiderne til mobilversioner, hvis siderne ikke bliver korrekt crawlet af smartphone Googlebot.

#3. HTTP-statuskode returneret af websider, når der anmodes om det

De seneste svarkoder, som vores websider returnerer, kan hentes enten ved hjælp af logfiler eller ved at bruge muligheden for at hente og gengive anmodning i Google Search Console.

Logfilanalysatorer kan finde siderne med 3xx-, 4xx- og 5xx-koderne. Du kan løse disse problemer ved at tage den relevante handling, for eksempel at omdirigere URL’erne til de korrekte destinationer eller ændre 302-statuskodet til 301.

#4. Analyse af crawl-aktiviteter som crawl-dybde eller interne links

Google sætter pris på din webstedsstruktur baseret på dens crawl-dybde og interne links. Årsager til ukorrekt crawl af webstedet kan være dårlig interlinkstruktur og crawldybde.

Hvis du har problemer med dit websteds hierarki eller webstedsstruktur eller interlinkstruktur, kan du bruge logfilanalyse til at finde dem.

Logfilanalyse hjælper med at optimere hjemmesidens arkitektur og interlinkstruktur.

#4. Oplev forældreløse sider

Forældreløse sider er de websider på webstedet, som ikke er linket fra nogen anden side. Det er svært for sådanne sider at blive indekseret eller blive vist i søgemaskiner, da de ikke let opdages af bots.

Forældreløse sider kan nemt opdages af crawlere som Screaming Frog, og dette problem kan løses ved at sammenkæde disse sider med de andre sider på webstedet.

#5. Revider siderne for sidehastighed og oplevelse

Sideoplevelse og kernevitaliteter på nettet er officielt rangeringsfaktorerne nu, og det er vigtigt nu, at websider er i overensstemmelse med Googles retningslinjer for sidehastighed.

Langsomme eller store sider kan opdages ved hjælp af logfilanalysatorer, og disse sider kan optimeres til sidehastighed, der vil hjælpe med den overordnede placering på SERP.

Logfilanalyse hjælper dig med at få kontrol over, hvordan dit websted crawles, og hvordan søgemaskiner håndterer dit websted

Nu, da vi er klare med det grundlæggende i logfiler og deres analyse, lad os se på processen med at revidere logfilerne til SEO

Sådan laver du logfilanalyse

Vi har allerede set på forskellige aspekter af logfiler og vigtigheden af SEO. Nu er det tid til at lære processen med at analysere filerne og de bedste værktøjer til at analysere logfilerne.

Du skal have adgang til webstedets serverlogfil for at få adgang til logfilen. Filerne kan analyseres på følgende måder:

Der er forskellige trin involveret i at få adgang til logfilerne manuelt.

- Indsaml eller eksporter logdataene fra webserveren, og dataene skal filtreres for søgemaskinens bots eller crawlere.

- Konverter den downloadede fil til et læsbart format ved hjælp af dataanalyseværktøjer.

- Analyser dataene manuelt ved hjælp af excel eller andre visualiseringsværktøjer for at finde SEO-huller og -muligheder.

- Du kan også bruge filtreringsprogrammer og kommandolinjer for at gøre dit job nemt

Manuelt arbejde med filernes data er ikke let, da det kræver viden om Excel og involverer udviklingsteamet. Alligevel gør værktøjer til logfilanalyse arbejdet nemt for SEO’er.

Lad os se på de bedste værktøjer til revision af logfilerne og forstå, hvordan disse værktøjer hjælper os med at analysere logfilerne.

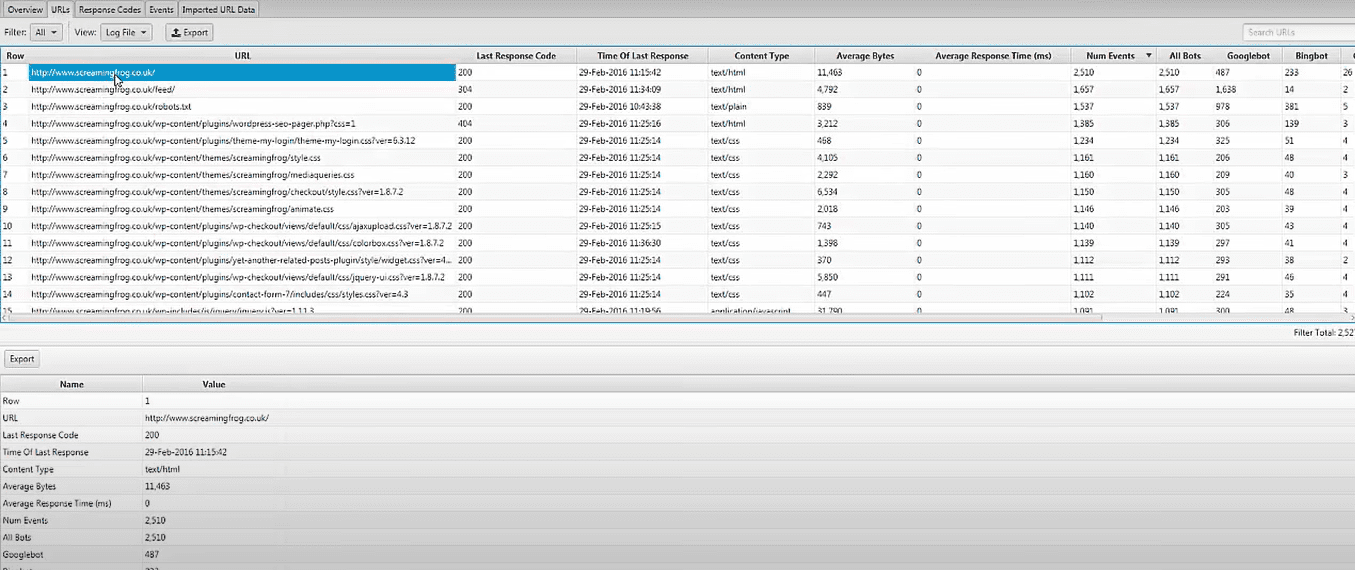

Screaming Frog Log File Analyzer

Tekniske SEO-problemer kan identificeres ved hjælp af uploadede logfildata og søgemaskine-bots verificeret ved hjælp af Screaming Frog Log File Analyzer. Du kan også gøre som følger:

- Søgemaskinebotaktivitet og data til søgemaskineoptimering.

- Opdag webstedets crawl-frekvens af søgemaskinebots

- Find ud af om alle de tekniske SEO-problemer og eksterne og interne ødelagte links

- Analyse af URL’er, der er blevet crawlet mindst og mest for at reducere tab og øge effektiviteten.

- Opdag sider, der ikke bliver crawlet af søgemaskiner.

- Alle data kan sammenlignes og kombineres, som inkluderer eksterne linkdata, direktiver og anden information.

- Se data om henvisnings-URL’er

Screaming Frog logfilanalysatorværktøj er helt gratis at bruge til et enkelt projekt med en grænse på 1000 linjeloghændelser. Du skal opgradere til den betalte version, hvis du ønsker ubegrænset adgang og teknisk assistance.

JetOctopus

Når det kommer til overkommelige loganalysatorværktøjer, er JetOctopus bedst. Det har en syv-dages gratis prøveperiode, intet kreditkort påkrævet, og en to-klik forbindelse. Crawlfrekvens, crawlbudget, mest populære sider og mere kan alle identificeres ved hjælp af JetOctopus loganalysatorligesom de andre værktøjer på vores liste.

Med dette værktøj kan du integrere logfildata med Google Search Console-data, hvilket giver dig en klar fordel i forhold til konkurrenterne. Med denne kombination vil du være i stand til at se, hvordan Googlebot interagerer med dit websted, og hvor du kan forbedre dig.

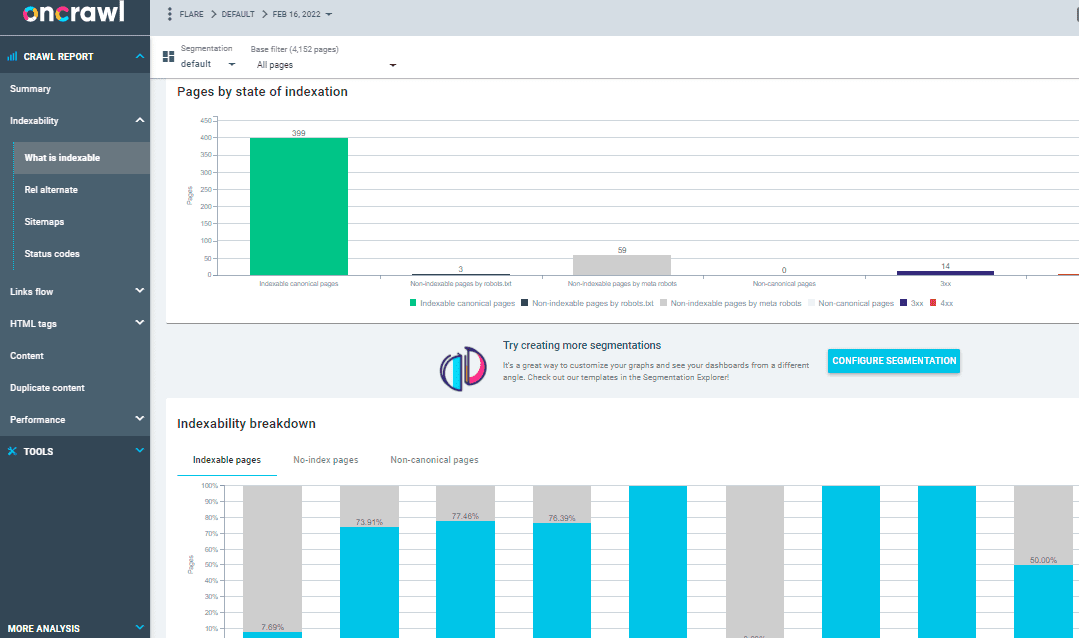

På Crawl Log Analyzer

Over 500 millioner log linjer om dagen behandles af Oncrawl Log Analyzer, et værktøj designet til mellemstore til store websteder. Det holder øje med dine webserverlogfiler i realtid for at sikre, at dine sider bliver korrekt indekseret og crawlet.

Oncrawl Log Analyzer er GDPR-kompatibel og yderst sikker. I stedet for IP-adresser gemmer programmet alle logfiler i en sikker og adskilt FTP-sky.

Udover JetOctopus og Screaming Frog Log File Analyzer har Oncrawl nogle flere funktioner, såsom:

- Understøtter mange logformater, såsom IIS, Apache og Nginx.

- Værktøjet tilpasser sig nemt til dine behandlings- og opbevaringskrav, efterhånden som de ændrer sig

- Dynamisk segmentering er et kraftfuldt værktøj til at afdække mønstre og sammenhænge i dine data ved at gruppere dine URL’er og interne links baseret på forskellige kriterier.

- Brug datapunkter fra dine rå logfiler til at oprette handlingsrettede SEO-rapporter.

- Logfiler, der overføres til dit FTP-rum, kan automatiseres ved hjælp af teknisk personale.

- Alle de populære browsere kan overvåges, det inkluderer Google, Bing, Yandex og Baidus crawlere.

OnCrawl Log Analyzer har to vigtigere værktøjer:

Oncrawl SEO-crawler: Med Oncrawl SEO Crawler kan du crawle dit websted med høj hastighed og med minimale ressourcer. Forbedrer brugerens forståelse af, hvordan placeringskriterier påvirker søgemaskineoptimering (SEO).

Oncrawl-data: Oncrawl-data analyserer alle SEO-faktorer ved at kombinere data fra crawlet og analyser. Den henter dataene fra crawl- og logfilerne for at forstå crawl-adfærden og anbefaler crawl-budgettet til prioriteret indhold eller rangeringssider.

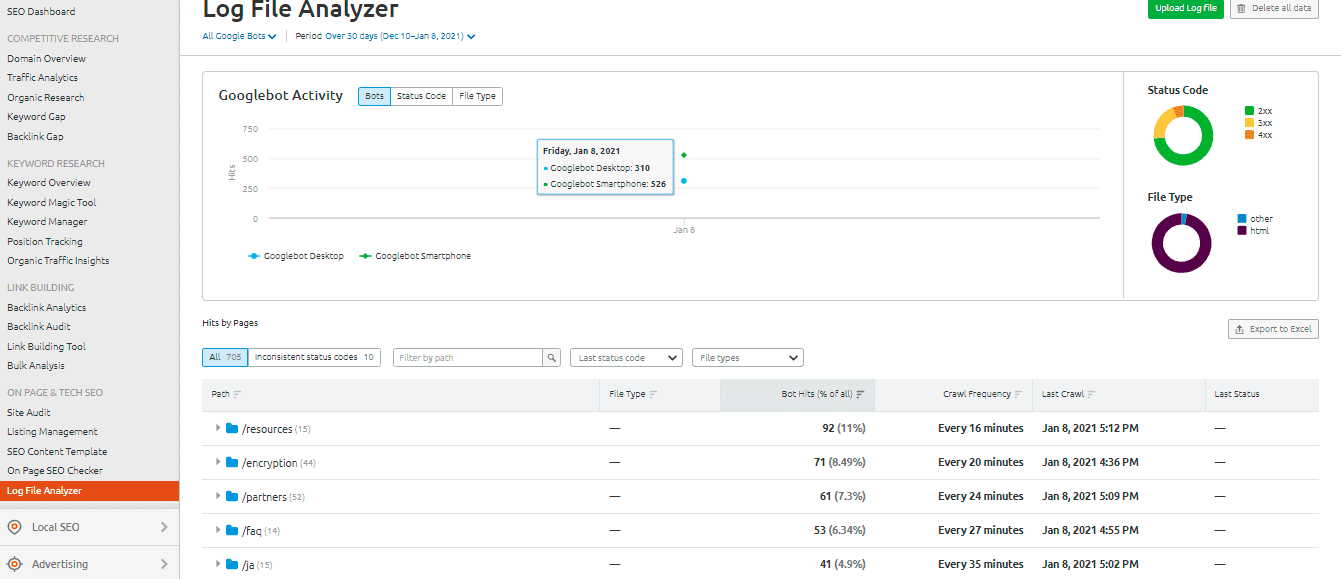

SEMrush Log File Analyzer

Det SEMrush Log File Analyzer er et smart valg til et ligetil, browserbaseret loganalyseværktøj. Denne analysator kræver ikke download og kan bruges i onlineversionen.

SEMrush præsenterer dig to rapporter:

Pages’ hits: Pages’ Hits rapporterer webcrawlernes interaktion med dit websteds indhold. Det giver dig data for sider, mapper og URL’er med maksimal og minimum interaktion med bots.

Aktiviteten af Googlebot: Googlebot-aktivitetsrapporten giver den webstedsrelaterede indsigt på daglig basis, såsom:

- Typerne af crawlede filer

- Den overordnede HTTP-statuskode

- Antallet af anmodninger til dit websted af forskellige bots

Loggly fra SolarWinds

SolarWinds’ Loggly undersøger adgangs- og fejllogfilerne på din webserver, samt webstedets ugentlige metrics. Du kan se dine logdata på ethvert tidspunkt, og det har funktioner, der gør det nemt at søge gennem logfiler.

Et robust logfilanalyseværktøj som SolarWinds Loggly er påkrævet for effektivt at mine logfilerne på din webserver for at få oplysninger om succes eller fiasko for ressourceanmodninger fra klienter.

Loggly kan levere diagrammer, der viser de mindst almindeligt viste sider og beregne gennemsnitlige, minimum og maksimale sideindlæsningshastigheder for at hjælpe dig med at optimere dit websteds søgemaskineoptimering.

Google Search Console Crawl-statistik

Google Search Console gjort tingene lettere for brugerne ved at give et nyttigt overblik over dets praksis. Konsollens betjening er ligetil. Din crawl-statistik vil derefter blive opdelt i tre kategorier:

- Kilobyte downloadet pr. dag: Det angiver de kilobytes, der downloades af Googlebots, mens de besøger webstedet. Dette indikerer grundlæggende to vigtige punkter: Hvis der vises høje gennemsnit i grafen, betyder det, at webstedet crawles oftere, eller det kan også indikere, at botten tager lang tid at crawle et websted, og det er ikke letvægtigt.

- Sider crawlet efter dag: Det fortæller dig antallet af sider, Googlebot crawler hver dag. Den noterer også crawlaktivitetsstatus, uanset om den er lav, høj eller gennemsnitlig. Lav crawlhastighed indikerer, at webstedet ikke er crawlet korrekt af Googlebot

- Tid brugt på at downloade en side (i millisekunder): Dette angiver den tid, det tager Googlebot at lave HTTP-anmodninger under crawl af webstedet. Mindre tid, Googlebot skal bruge på at lave anmodninger, vil det være at downloade siden bedre, da indeksering vil være hurtigere.

Konklusion

Jeg håber, du har fået meget ud af denne guide om logfilanalyse og værktøjer, der bruges til at revidere logfilerne til SEO. Revision af logfilerne kan være meget effektiv til at forbedre de tekniske SEO-aspekter af hjemmesiden.

Google Search Console og SEMrush Log File Analyzer er to muligheder for et gratis og grundlæggende analyseværktøj. Som et alternativ kan du tjekke Screaming Frog Log File Analyzer, JetOctopus eller Oncrawl Log Analyzer for bedre at forstå, hvordan søgemaskinebots interagerer med dit websted; du kan bruge blandede premium og gratis logfiler analyseværktøjer til SEO.

Du kan også kigge på nogle avancerede webstedscrawlere for at forbedre SEO.