Din one-stop-forklaring på Deepfakes og for at gøre dem nemt med Faceswap.

Kunstig intelligens er ikke så ‘kunstig’ længere. Disse tider har bragt det farligt tæt på os mennesker.

Det kan foreslå, skrive, skabe kunst og nu ser og taler som de levende.

Dette er en af de seneste udviklinger på dette område, vi bør drage fordel af. Det er dog også noget, vi skal passe på.

Indholdsfortegnelse

Hvad er Deepfakes?

Ordet Deepfake er opfundet ved at kombinere deep learning og falsk. Enkelt sagt kan du også antage, at dette er ekspertmanipulerede eller dybt falske medier.

Ifølge Wikipedia er dette også kendt som syntetiske medier, hvor et eksisterende billede, lyd eller video er ændret til at repræsentere en helt anden.

Typisk får deepfakes kendte personligheder til at synes at sige noget, de ellers ikke ville.

Baseret på dens skabers færdigheder, kan det være ekstremt svært at sige, om det er ægte eller falsk.

Hvordan virker Deepfakes?

Forenklet sagt er en del af den originale video (f.eks. et ansigt) erstattet af en lignende falsk ud. I sådan et tilfælde kan det også kaldes en faceswap, som i denne ‘Obama’-video.

Det er dog ikke begrænset til video alene, og vi har også deepfakes-billeder og lyd (og hvem ved, deepfake VR-avatarer i den nærmeste fremtid).

Kilde: Disney

Arbejdsmetoden bag sådanne tricker afhænger primært af applikationen og den underliggende algoritme.

I henhold til dette forskningspapir af Disney er der forskellige teknikker, herunder indkoder-dekodere, Generative Adversarial Networks (GAN’er), geometribaserede deepfakes osv.

De følgende afsnit er dog i høj grad påvirket af, hvordan det fungerer med Facewap. Dette er en gratis og open source Deepfake-software, der giver mulighed for flere algoritmer for at få det forventede resultat.

Der er tre store processer til at generere deepfakes: udvinding, træning og konvertering.

#1. Udvinding

Dette handler om at opdage og presse emneområdet af interesse fra medieeksempler, originalen og den til byttet.

Baseret på hardwarefunktionerne kan der være mange algoritmer til at vælge effektiv detektion.

For eksempel har Faceswap et par forskellige muligheder for ekstraktion, justering og maskering baseret på CPU- eller GPU-effektivitet.

Ekstraktion identificerer blot ansigtet i den samlede video. Justering pletter afgørende træk ved ethvert ansigt (øjne, næse, hage osv.). Og til sidst blokerer maskering andre elementer i billedet ud over interesseområdet.

Den samlede tid, det tager for outputtet, er vigtig ved valg af enhver mulighed, da valg af ressourcekrævende algoritmer på middelmådig hardware kan resultere i fejl eller betydelig lang tid til at give acceptable resultater.

Udover hardwaren afhænger valget også af parametrene, såsom om inputvideoen lider af ansigtsobstruktioner som håndbevægelser eller briller.

Et nødvendigt element i sidste ende er at rense (forklaret senere) outputtet, da ekstraktionerne vil have et par falske positiver.

I sidste ende gentages udtrækningen for den originale video og den falske (bruges til at bytte).

#2. Uddannelse

Dette er hjertet i at skabe deepfakes.

Træning handler om det neurale netværk, som består af koder og dekoder. Her bliver algoritmerne fodret med de udtrukne data for at skabe en model for konverteringen senere.

Indkoderen konverterer inputtet til en vektorrepræsentation for at træne algoritmen til at genskabe ansigterne tilbage fra vektorer, som gjort af dekoderen.

Bagefter evaluerer det neurale netværk sine iterationer og sammenligner dem med originalen ved at tildele en tabsscore. Denne tabsværdi falder over tid, efterhånden som algoritmen bliver ved med at iterere, og du stopper, når forhåndsvisningerne er acceptable.

Træning er en tidskrævende proces, og outputtet forbedres generelt baseret på de iterationer, den udfører, og kvaliteten af inputdata.

For eksempel foreslår Faceawap mindst 500 billeder hver, originale og til ombytning. Derudover bør billederne adskille sig væsentligt indbyrdes, og dække alle mulige vinkler i unik belysning for den bedste rekreation.

På grund af træningslængden giver nogle applikationer (såsom Faceswap) mulighed for at stoppe træningen midtvejs eller fortsætte senere.

Især afhænger fotorealismen af outputtet også af algoritmens effektivitet og input. Og man er igen begrænset af hardware-mulighederne.

#3. Konvertering

Dette er det sidste kapitel i den deepfake-skabelse. Konverteringsalgoritmerne har brug for kildevideoen, den trænede model og kildejusteringsfilen.

Efterfølgende kan man ændre nogle få muligheder i forhold til farvekorrektion, masketype, ønsket outputformat osv.

Efter at have konfigureret disse få muligheder, venter du bare på den endelige gengivelse.

Faceswap fungerer som nævnt med mange algoritmer, og man kan spille imellem for at få en tålelig faceswap.

Er det alt?

Ingen!

Dette var bare ansigtsbytte, en undergruppe af deepfake-teknologi. Ansigtsbytte, ligesom den bogstavelige betydning, erstatter kun en del af ansigtet for at give en svag idé om, hvad deepfakes kunne gøre.

For et troværdigt bytte skal du muligvis også efterligne lyden (bedre kendt som stemmekloning) og hele fysikken, inklusive alt, der passer i rammen, sådan her:

Så hvad er der på spil her?

Det, der kunne være sket, er, at den deepfake-forfatter selv optog videoen (som angivet i de sidste par sekunder), læbesynkroniserede dialogen med Morgan Freemans syntetiske stemme og skiftede hovedet.

Afslutningsvis handler det ikke kun om faceswap, men hele rammen, inklusive lyden.

Du kan finde tonsvis af deepfakes på YouTube til det punkt, hvor det bliver skræmmende med, hvad man skal stole på. Og alt, der skal til, er en kraftfuld computer med et effektivt grafikkort for at komme i gang.

Perfektion er dog svært at opnå, og det gælder især med deepfakes.

For en overbevisende deepfake, der kan vildlede eller imponere, kræver publikum dygtighed og et par dage til ugers behandling for et minut eller to af en video.

Interessant nok er det så dygtige disse algoritmer er lige nu. Men hvad fremtiden byder på, inklusive hvor effektive disse applikationer kan være på hardware i lavere ende, er noget, der har gjort hele regeringer nervøse.

Vi vil dog ikke dykke ned i dets fremtidige konsekvenser. Lad os i stedet tjekke, hvordan du gør det selv for lidt sjov.

Oprettelse af (grundlæggende) Deepfake-videoer

Du kan tjekke mange applikationer på denne liste over deepfake apps til at lave memes.

En af dem er Faceswap, som vi kommer til at bruge.

Der er et par ting, vi vil sikre os, før vi fortsætter. For det første bør vi have en video af god kvalitet af målet, der viser forskellige følelser. Dernæst skal vi bruge en kildevideo for at skifte til målet.

Derudover skal du lukke alle de grafikkortintensive programmer som browsere eller spil, før du fortsætter med Faceswap. Dette gælder især, hvis du har mindre end 2 koncerter VRAM (video RAM).

Trin 1: Udpakning af ansigter

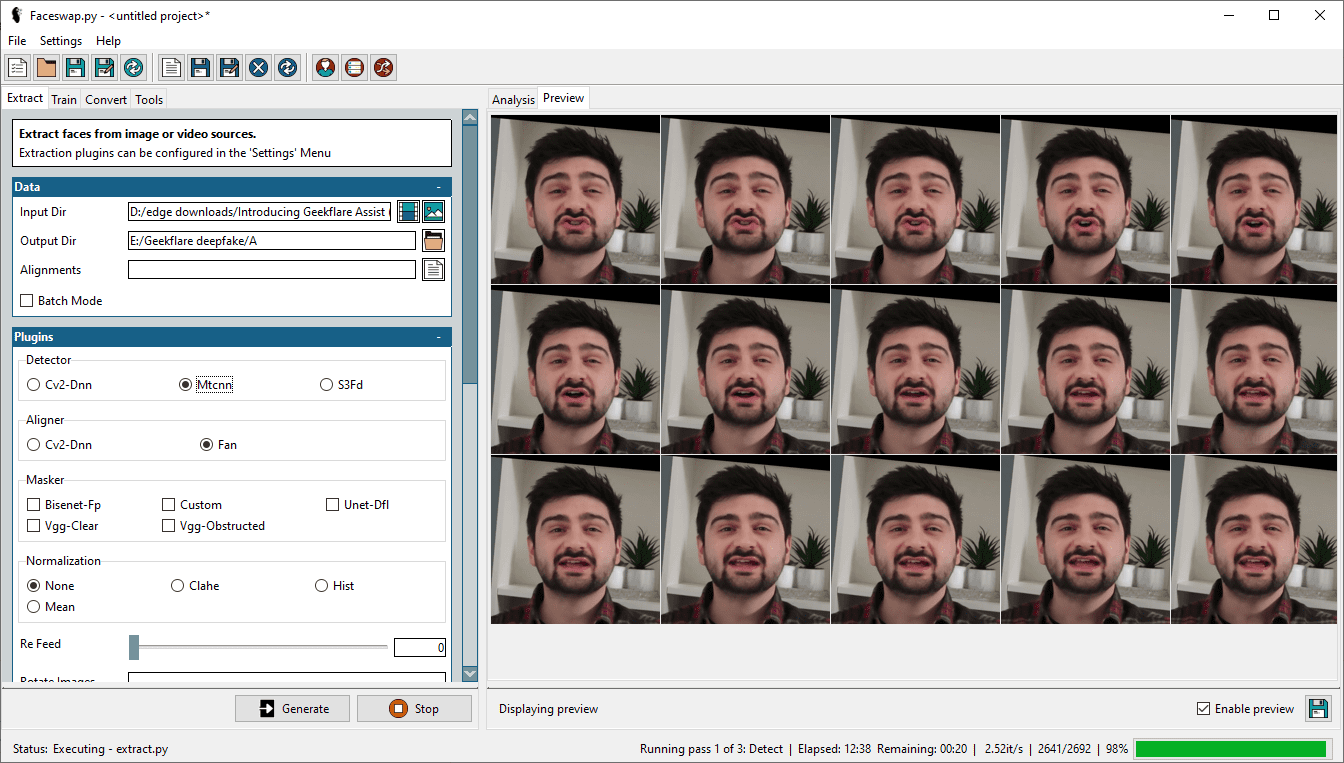

Det første trin i denne proces er at udtrække ansigterne fra videoen. Til dette skal vi vælge målvideoen i Input Dir og angive en Output Dir for ekstraktionerne.

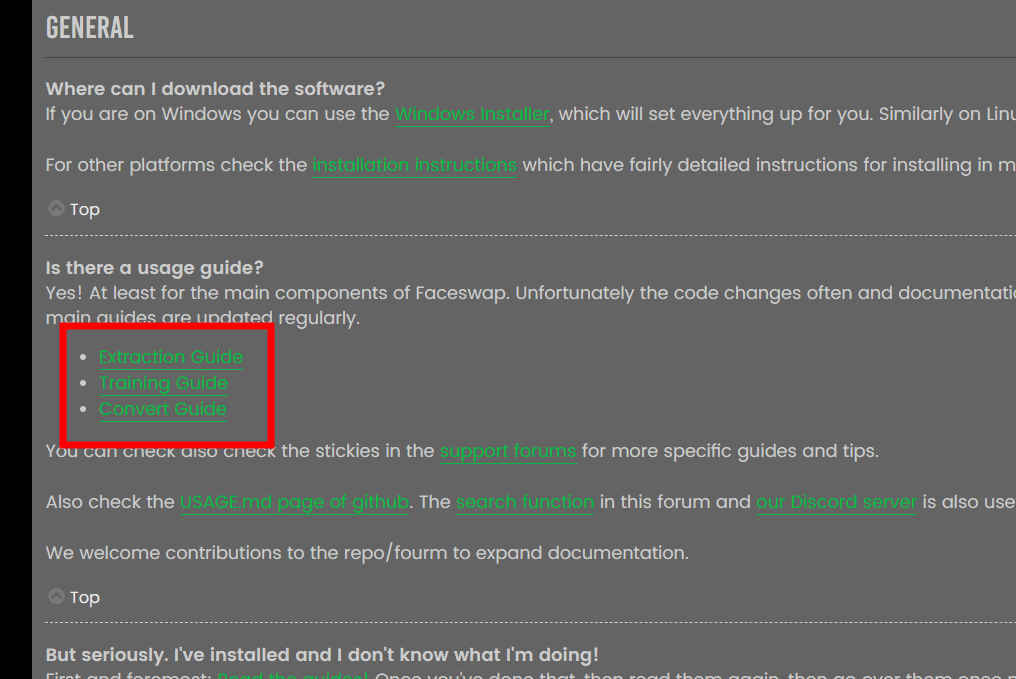

Derudover er der et par muligheder, herunder detektor, aligner, masker osv.; forklaringerne for hver er i Faceawap ofte stillede spørgsmål, og det ville være spild at gentage oplysningerne her.

Kilde: Faceswap FAQ

Kilde: Faceswap FAQ

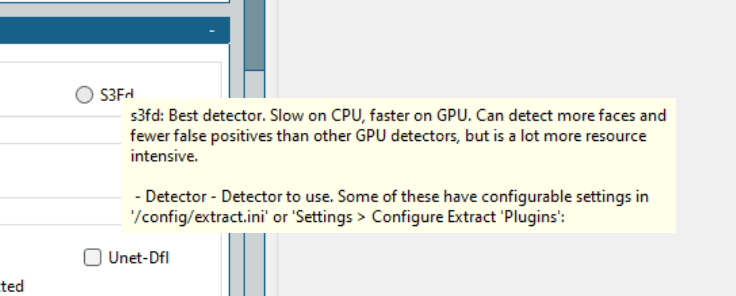

Det er generelt godt at gennemgå dokumentationen for en bedre forståelse og et anstændigt output. Der er dog nyttige tekster i Faceswap, du kan finde ved at holde markøren over den specifikke mulighed.

Kort sagt er der ingen universel måde, og man bør starte med de bedste algoritmer og arbejde sig ned med succes for at skabe en overbevisende deepfake.

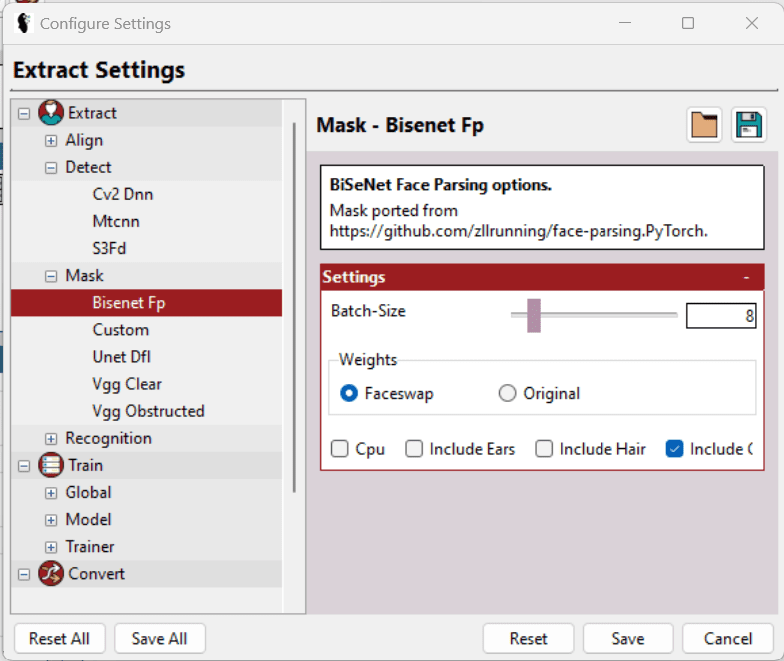

Til kontekst brugte jeg Mtcnn (detektor), Fan (aligner) og Bisenet-Fp (masker), mens jeg beholdt alle de andre muligheder, som de er.

Oprindeligt prøvede jeg det med S3Fd (bedste detektor) og et par andre masker kombineret. Min 2Gb Nvidia GeForce GTX 750Ti kunne dog ikke bære byrden, og processen mislykkedes gentagne gange.

Til sidst nedtonede jeg mine forventninger og indstillingerne for at se det igennem.

Udover at vælge den passende detektor, maskere osv., er der et par flere muligheder i Indstillinger > Konfigurer indstillinger, som hjælper med at finjustere individuelle indstillinger yderligere for at hjælpe hardwaren.

Kort sagt, vælg den lavest mulige Batch-Size, Input Size og Output Size, og marker LowMem osv. Disse muligheder er ikke tilgængelige universelt, og de er baseret på en specifik sektion. Derudover hjælper hjælpeteksterne yderligere med at vælge de bedste muligheder.

Selvom dette værktøj gør et fremragende stykke arbejde med at udtrække ansigter, kan outputframes have meget mere end nødvendigt for at træne (omtalt senere) modellen. For eksempel vil den have alle ansigter (hvis videoen har mere end én) og nogle ukorrekte registreringer, der slet ikke har målansigtet.

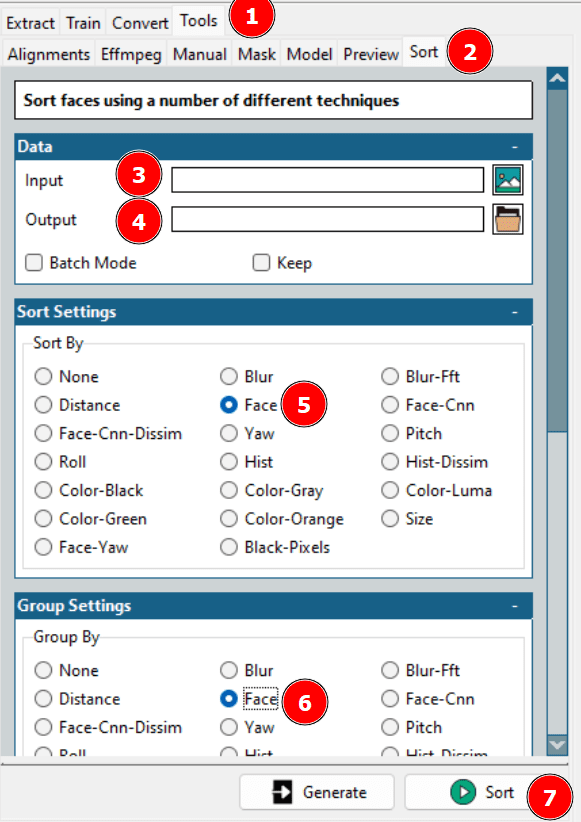

Dette fører til rensning af datasættene. Enten kan man tjekke output-mappen og slette sig selv eller bruge Faceswap-sorteringen for at få lidt hjælp.

Brug af det førnævnte værktøj vil arrangere forskellige ansigter i rækkefølge, hvorfra du kan lægge de nødvendige sammen i en enkelt mappe og slette resten.

Som en påmindelse vil du også gerne gentage ekstraktion for den kildevideo.

Trin 2: Træning af modellen

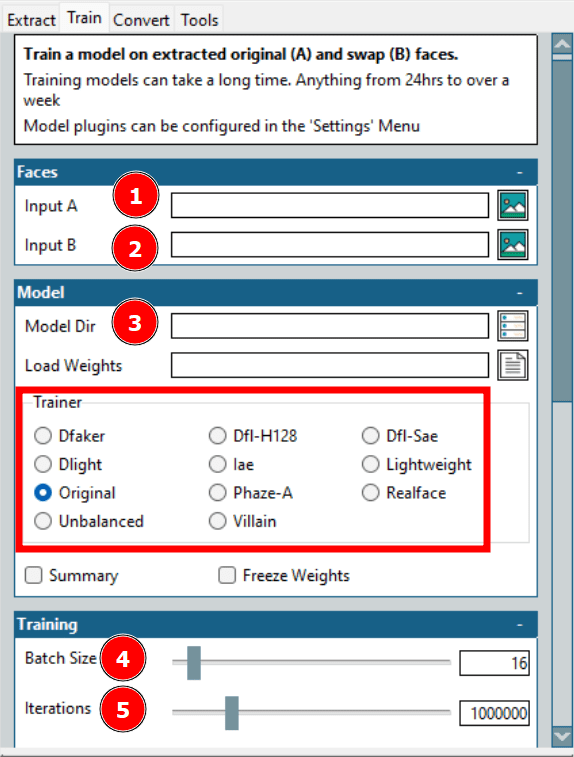

Dette er den længste proces i at skabe en deepfake. Her refererer Input A til målfladen, og Input B handler om kildefladen. Desuden er Model Dir, hvor træningsfilerne gemmes.

Her er den vigtigste mulighed Trainer. Der er masser med individuelle skaleringsmuligheder; Men det, der virkede for min hardware, er Dfl-H128 og letvægts-trænere med de laveste konfigurationsindstillinger.

Dernæst er batchstørrelsen. En højere batchstørrelse reducerer den samlede træningstid, men bruger mere VRAM. Gentagelser har ingen fast effekt på outputtet, og du bør indstille en høj nok værdi og stoppe træningen, når forhåndsvisningerne er acceptable.

Der er et par flere indstillinger, herunder oprettelse af en timelapse med forudindstillede intervaller; dog trænede jeg modellen med det absolutte minimum.

Trin 3: Skift til original

Dette er den sidste bedrift i deepfake-skabelsen.

Dette tager generelt ikke så meget tid, og du kan spille med mange muligheder for at få det ønskede output hurtigt.

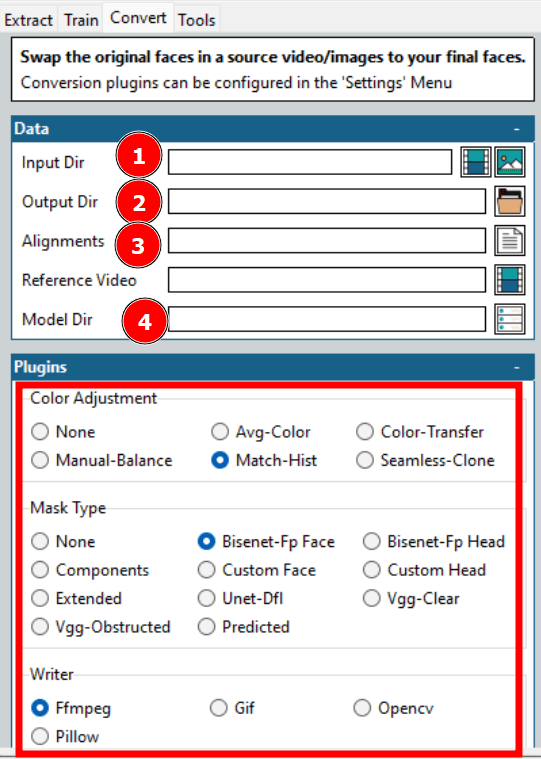

Som angivet i ovenstående billede, er dette et par muligheder, man skal vælge for at starte konverteringen.

De fleste muligheder er allerede diskuteret, såsom Input- og Output-mappen, Model-mappen osv. En afgørende ting er Alignments, som refererer til alignment-filen (.fsa) for målvideoen. Det bliver oprettet i Input Directory under udtrækningen.

Feltet Justeringer kan stå tomt, hvis den specifikke fil ikke er blevet flyttet. Ellers kan man vælge filen og gå videre til andre muligheder. Husk dog at rense alignment-filen, hvis du har renset ekstraktionerne tidligere.

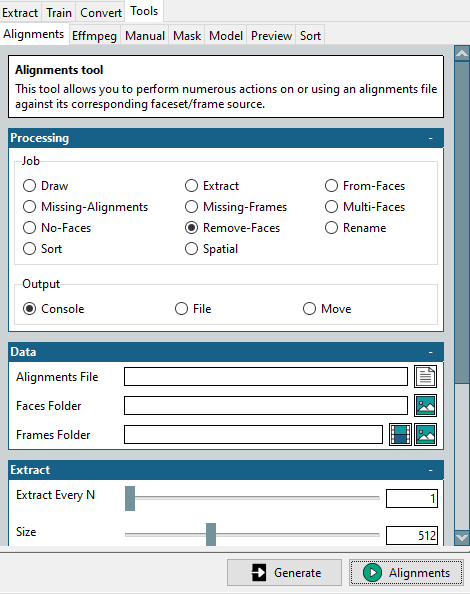

Til dette ligger dette miniværktøj i Tools > Alignments.

Start med at vælge Fjern-ansigter i Job-sektionen, vælg den originale justeringsfil og mappen med rensede målflader, og klik på Justeringer nederst til højre.

Dette vil oprette en ændret justeringsfil, der matcher mappen med optimerede ansigter. Husk, at vi skal bruge dette til målvideoen, som vi vil bytte til.

Et par flere konfigurationer inkluderer farvejustering og masketype. Farvejustering dikterer maskeblandingen, og du kan prøve et par stykker, tjekke forhåndsvisningen og vælge den optimale mulighed.

Masketype er vigtigere. Dette afhænger igen af dine forventninger og den tilgængelige hardware. Typisk skal du også overveje inputvideoens egenskaber. For eksempel fungerer Vgg-Clear godt med frontale ansigter uden forhindringer, hvorimod Vgg-Obstructed også kan klare forhindringer, såsom håndbevægelser, briller osv.

Dernæst præsenterer Writer et par valg baseret på det output, du ønsker. For f.eks. skal du vælge Ffmpeg for en videogengivelse.

Samlet set er nøglen til en vellykket deepfake at forhåndsvise nogle få udgange og optimere i henhold til den tilgængelige tid og hardwarens styrke.

Anvendelser af Deepfake

Der er gode, dårlige og farlige anvendelser af deepfakes.

De gode består i at genskabe historielektioner af dem, der faktisk var der for større engagement.

Derudover bliver de brugt af online læringsplatforme til at generere videoer fra tekster.

Men en af de største fordele vil være filmindustrien. Her vil det være nemt at forestille sig den faktiske hovedrolle, der udfører stunts, selv når det vil være stuntpersonen, der risikerer deres liv. Derudover vil det være nemmere end nogensinde at lave flersprogede film.

Kommer til de dårlige, er der desværre mange. Den største deepfake-applikation til dato, faktisk, 96% (i henhold til denne Deeptrace-rapport), er i pornoindustrien for at bytte berømthedsansigter ud med pornoskuespillere.

Derudover er deepfakes også bevæbnet mod ‘standard’ kvinder, der ikke er kendte. Normalt har sådanne ofre fotografier eller videoer af høj kvalitet på deres sociale medieprofiler, som bruges til at lave deepfakes.

En anden skræmmende applikation er vishing, også kaldet voice phishing. I et sådant tilfælde overførte administrerende direktør for et britisk-baseret firma 243.000 dollars på ordre fra “CEO” for dets tyske moderselskab, for senere at finde ud af, at det faktisk var et dybt falsk telefonopkald.

Men hvad der er endnu mere farligt, er deepfake, der provokerer krige eller beder om overgivelse. Et seneste forsøg har set den ukrainske præsident, Volodymyr Zelenskyy, fortælle sine styrker og folk om at overgive sig i den igangværende krig. Sandheden denne gang blev dog givet væk af den underordnede video.

Endeligt er der mange deepfake-applikationer, og det er lige begyndt.

Dette bringer os til million-dollar-spørgsmålet…

Er Deepfakes lovligt?

Dette afhænger i høj grad af den lokale administration. Selvom veldefinerede love, herunder hvad der er tilladt og hvad der ikke er, endnu ikke er set.

Alligevel er det indlysende, at det afhænger af, hvad du bruger deepfakes til – hensigten. Der er næppe nogen skade, hvis du har til hensigt at underholde eller uddanne nogen uden at forstyrre byttemålet.

På den anden side bør ondsindede ansøgninger være strafbare ved lov, uanset jurisdiktion. En anden gråzone er krænkelse af ophavsretten, som skal overvejes ordentligt.

Men for at gentage, bør du tjekke med dine lokale regeringsorganer om lovlige deepfake-applikationer.

Hold øje!

Deepfkaes udnytter kunstig intelligens til at få nogen til at sige ting.

Stol ikke på noget, du ser på internettet, er det første råd, vi bør handle efter. Der er tonsvis af misinformation, og deres effektivitet er kun stigende.

Og da det kun bliver nemmere at skabe dem, er det på tide, at vi lærer at spotte deepfakes.