Der findes terabyte og petabyte af data i denne internetalder, med eksponentiel vækst på samme måde. Men hvordan bruger vi disse data og oversætter dem til nyttige oplysninger for at forbedre servicetilgængeligheden?

Gyldige, nye og forståelige data er alt, hvad virksomheder har brug for til deres videnopdagelsesmodeller.

Af denne grund anvender virksomheder analyser på mange forskellige måder for at afdække kvalitetsdata.

Men hvor starter det hele? Svaret er datastrid.

Lad os komme igang!

Indholdsfortegnelse

Hvad er datastrid?

Datastrid er handlingen med at rense, strukturere og transformere rå data til formater, der forenkler dataanalyseprocesser. Datastrid involverer ofte arbejde med rodede og komplekse datasæt, der ikke er klar til datapipeline-processer. Datastrid flytter rådata til en raffineret tilstand eller raffinerede data til optimeret tilstand og produktionsklar niveau.

Nogle af de kendte opgaver i datastrid omfatter:

- Sammenlægning af flere datasæt til ét stort datasæt til analyse.

- Undersøgelse af manglende/huller i data.

- Fjernelse af outliers eller anomalier i datasæt.

- Standardisering af input.

De store datalagre, der er involveret i datastridsprocesser, er normalt længere end manuel tuning, hvilket nødvendiggør automatiserede dataforberedelsesmetoder for at producere mere nøjagtige og kvalitetsdata.

Mål for datastrid

Udover at forberede data til analyse som det større mål, omfatter andre mål:

- Oprettelse af gyldige og nye data ud af rodet data for at drive beslutningstagning i virksomheder.

- Standardisering af rådata til formater, som Big Data-systemer kan indtage.

- Reduktion af den tid, dataanalytikere bruger på at skabe datamodeller ved at præsentere ordnede data.

- Skaber konsistens, fuldstændighed, brugervenlighed og sikkerhed for ethvert datasæt, der forbruges eller opbevares i et datavarehus.

Fælles tilgange til datastrid

Opdagende

Før dataingeniører påbegynder dataforberedelsesopgaver, skal de forstå, hvordan de er lagret, størrelsen, hvilke poster der opbevares, kodningsformaterne og andre attributter, der beskriver et datasæt.

Strukturering

Denne proces involverer at organisere data til at tage let anvendelige formater. Rå datasæt skal muligvis struktureres i, hvordan kolonnerne vises, antallet af rækker og justering af andre dataattributter for at forenkle analysen.

Rengøring

Strukturerede datasæt skal fjernes med iboende fejl og alt, der kan skævvride dataene indeni. Rengøring indebærer således fjernelse af flere celleindgange med lignende data, sletning af tomme celler og afvigende data, standardisering af input, omdøbning af forvirrende attributter og mere.

Berigende

Når data har bestået strukturerings- og rensningsstadierne, er det nødvendigt at vurdere datanytten og udvide den med værdier fra andre datasæt, der mangler for at give den ønskede datakvalitet.

Validerer

Valideringsprocessen indebærer iterative programmeringsaspekter, der kaster lys over datakvalitet, konsistens, brugervenlighed og sikkerhed. Valideringsfasen sikrer, at alle transformationsopgaver er opnået, og markerer datasæt som klar til analyse- og modelleringsfaser.

Præsenterer

Når alle stadier er bestået, præsenteres/deltes de omstridte datasæt i en organisation til analyse. Dokumentation af forberedelsestrin og metadata genereret under skænderiprocessen deles også i denne fase.

Talent

Talent er en samlet datastyringsplatform pakket ind i 3 datastrukturer for at levere pålidelige og sunde data. Talend præsenterer Dataintegration, Applikation og Integration og Data Integrity & Governance. Datastrid i Talend foregår gennem et browserbaseret peg og klik-værktøj, der tillader batch-, bulk- og livedataforberedelser – dataprofilering, rensning og dokumentation.

Talend datastof håndterer alle stadier af datalivscyklussen og balancerer omhyggeligt datatilgængelighed, brugervenlighed, sikkerhed og integritet af alle forretningsdata.

Har du nogensinde været bekymret for dine forskellige datakilder? Talends forenede tilgang giver hurtig dataintegration fra alle dine datakilder (databaser, cloud-lager og API-endepunkter) – hvilket muliggør transformation og kortlægning af alle data med problemfri kvalitetskontrol.

Dataintegration i Talend er aktiveret gennem selvbetjeningsværktøjer såsom connectors, der gør det muligt for udviklere at indtage data fra enhver kilde automatisk og korrekt kategorisere dataene.

Funktioner af Talend

Universel dataintegration

Talend giver virksomheder mulighed for at skændes med enhver datatype fra forskellige datakilder – Cloud- eller On-prem-miljøer.

Fleksibel

Talend går ud over leverandør eller platform, når du bygger datapipelines ud af dine integrerede data. Når du har oprettet datapipelines ud af dine indtagne data, giver Talend dig mulighed for at køre pipelines hvor som helst.

Datakvalitet

Med maskinlæringsfunktioner såsom datadeduplikering, validering og standardisering renser Talend automatisk indtagne data.

Understøttelse af applikations- og API-integrationer

Efter mening er skabt ud af dine data gennem Talends selvbetjeningsværktøjer, kan du dele dine data gennem brugervenlige API’er. Talend API-endepunkter kan eksponere dine dataaktiver for SaaS-, JSON-, AVRO- og B2B-platforme gennem avancerede datakortlægnings- og transformationsværktøjer.

R

R er et veludviklet og effektivt programmeringssprog til at tackle undersøgende dataanalyse til videnskabelige og forretningsmæssige applikationer.

Bygget som gratis software til statistisk databehandling og grafik er R både et sprog og et miljø til datastrid, modellering og visualisering. R-miljøet giver en suite af softwarepakker, mens R-sproget integrerer en række statistiske, klynge-, klassifikations-, analyse- og grafiske teknikker, der hjælper med at manipulere data.

Funktioner af R

Rigt sæt pakker

Dataingeniører har mere end 10.000 standardiserede pakker og udvidelser at vælge imellem fra Comprehensive R Archive Network (CRAN). Dette forenkler skænderier og dataanalyse.

Ekstremt kraftfuld

Med distribuerede computerpakker tilgængelige, kan R udføre komplekse og ligetil manipulationer (matematiske og statistiske) på dataobjekter og datasæt inden for få sekunder.

Support på tværs af platforme

R er platform-uafhængig, i stand til at køre på mange operativsystemer. Det er også kompatibelt med andre programmeringssprog, der hjælper med at manipulere beregningstunge opgaver.

Det er nemt at lære R.

Trifacta

Trifacta er et interaktivt cloudmiljø til profilering af data, der køres mod maskinlærings- og analysemodeller. Dette dataingeniørværktøj har til formål at skabe forståelige data uanset hvor rodet eller komplekse datasættene er. Brugere kan fjerne dobbeltindtastninger og udfylde tomme celler i datasæt gennem deduplikering og lineære transformationstransformationer.

Dette værktøj til strid om data har øje for outliers og ugyldige data i ethvert datasæt. Med blot et klik og træk bliver data ved hånden rangeret og intelligent transformeret ved hjælp af forslag drevet af Machine learning for at accelerere dataforberedelsen.

Datastrid i Trifacta er gennem overbevisende visuelle profiler, der kan rumme ikke-tekniske og tekniske medarbejdere. Med de visualiserede og intelligente transformationer er Trifacta stolt af sit design til brugere i tankerne.

Uanset om de indtager data fra datamarts, datavarehuse eller datasøer, er brugere beskyttet mod kompleksiteten af dataforberedelser.

Funktioner af Trifacta

Sømløse cloud-integrationer

Understøtter forberedelsesarbejdsbelastninger på tværs af ethvert sky- eller hybridmiljø for at give udviklere mulighed for at indtage datasæt til skænderier, uanset hvor de bor.

Flere data Standardiseringsmetoder

Trifacta wrangler har flere mekanismer til at identificere mønstre i data og standardisere output. Dataingeniører kan vælge standardisering efter mønster, efter funktion eller mix og match.

Enkel arbejdsgang

Trifacta organiserer dataforberedelsesarbejde i form af flows. Et flow indeholder et eller flere datasæt plus deres tilknyttede opskrifter (definerede trin, der transformerer data).

Et flow reducerer derfor den tid, udviklere bruger på at importere, skændes, profilere og eksportere data.

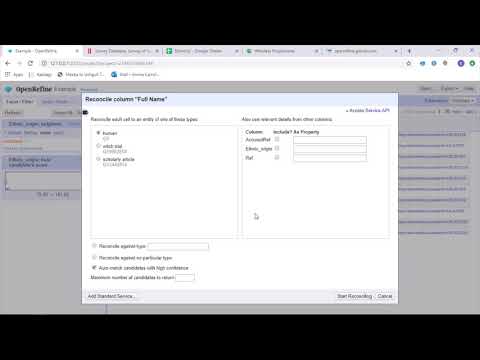

OpenRefine

OpenRefine er et modent, open source-værktøj til at arbejde med rodet data. Som et datarensningsværktøj udforsker OpenRefine datasæt i løbet af få sekunder, mens komplekse celletransformationer anvendes til at præsentere ønskede dataformater.

OpenRefine nærmer sig datastrid gennem filtre og partitioner på datasæt ved hjælp af regulære udtryk. Ved at bruge det indbyggede General Refine Expression Language kan dataingeniører lære og se data ved hjælp af facetter, filtre og sorteringsteknikker, før de udfører avancerede dataoperationer til enhedsudtræk.

OpenRefine giver brugerne mulighed for at arbejde på data som projekter, hvor datasæt fra flere computerfiler, web-URL’er og databaser kan trækkes ind i sådanne projekter med mulighed for at køre lokalt på brugernes maskiner.

Gennem udtryk kan udviklere udvide dataoprydning og -transformation til opgaver som at opdele/sammenføje celler med flere værdier, tilpasse facetter og hente data i kolonner ved hjælp af eksterne URL’er.

Funktioner i OpenRefine

Cross-platform værktøj

OpenRefine er bygget til at fungere med Windows, Mac og Linux operativsystemer gennem downloadbare installationsindstillinger.

Rigt sæt af API’er

Indeholder OpenRefine API, dataudvidelses-API, afstemnings-API og andre API’er, der understøtter brugernes interaktion med data.

Datameer

Datameer er et SaaS-datatransformationsværktøj bygget til at forenkle datamunging og integration gennem softwareudviklingsprocesser. Datameer muliggør udtrækning, transformation og indlæsning af datasæt til Cloud-datavarehuse såsom Snowflake.

Dette værktøj til at skændes med data fungerer godt med standarddatasætformater såsom CSV og JSON, hvilket gør det muligt for ingeniører at importere data i forskellige formater til aggregering.

Datameer har kataloglignende datadokumentation, dyb dataprofilering og opdagelse for at opfylde alle datatransformationsbehov. Værktøjet holder en dyb visuel dataprofil, der giver brugerne mulighed for at spore ugyldige, manglende eller afsidesliggende felter og værdier og den overordnede form af data.

Datameer, der kører på et skalerbart datavarehus, transformerer data til meningsfuld analyse gennem effektive datastacke og excel-lignende funktioner.

Datameer præsenterer en hybrid-, kode- og kodefri brugergrænseflade til at rumme brede dataanalyseteams, der nemt kan bygge komplekse ETL-pipelines.

Funktioner af Datameer

Flere brugermiljøer

Indeholder miljøer til transformation af flere personer – lav kode, kode og hybrid, for at understøtte teknologikyndige og ikke-teknologiske personer.

Delte arbejdsområder

Datameer giver teams mulighed for at genbruge og samarbejde om modeller for at fremskynde projekter.

Rig data dokumentation

Datameer understøtter både system- og brugergenereret datadokumentation gennem metadata og beskrivelser, tags og kommentarer i wiki-stil.

Sidste ord 👩🏫

Dataanalyse er en kompleks proces, som kræver, at dataene er passende organiseret til at drage meningsfulde slutninger og foretage forudsigelser. Værktøjer til datastrid hjælper dig med at formatere store mængder rådata for at hjælpe dig med at udføre avancerede analyser. Vælg det bedste værktøj, der passer til dit behov, og bliv en Analytics-professionel!

Du kan lide:

Bedste CSV-værktøjer til at konvertere, formatere og validere.