Med ankomsten af nye teknologier som deep learning, AI og ML er cloud GPU’er i høj efterspørgsel.

Hvis din organisation beskæftiger sig med 3D-visualiseringer, maskinlæring (ML), kunstig intelligens (AI) eller tung databehandling af en slags, betyder det meget, hvordan du udfører GPU-beregning.

Traditionelt tog dybe læringsmodeller i organisationer meget tid til træning og beregningsopgaver. Det plejede at dræbe deres tid, koste dem meget og efterlod dem med lager- og pladsproblemer, hvilket reducerede produktiviteten.

Den nye tids GPU’er er designet til at løse dette problem. De tilbyder høj effektivitet til at udføre tunge beregninger og hurtigere træning for dine AI-modeller parallelt.

Ifølge Indigo-forskning kan GPU’er tilbyde 250 gange hurtigere ydeevne end CPU’er, mens de træner neurale netværk forbundet med dyb læring.

Og med fremskridtene inden for cloud computing har vi cloud-GPU’er nu, der transformerer verden af datavidenskab og andre nye teknologier ved at tilbyde endnu hurtigere ydeevne, nem vedligeholdelse, reducerede omkostninger, hurtig skalering og sparer tid.

Denne artikel vil introducere dig til cloud GPU-koncepter, hvordan det relaterer til AI, ML, deep learning og nogle af de bedste cloud GPU-platforme, du kan finde til at implementere din foretrukne cloud-GPU.

Lad os begynde!

Indholdsfortegnelse

Hvad er en Cloud GPU?

For at forstå en cloud GPU, lad os først tale om GPU’er.

En Graphics Processing Unit (GPU) refererer til et specialiseret elektronisk kredsløb, der bruges til at ændre og manipulere hukommelsen hurtigt for at fremskynde skabelsen af billeder eller grafik.

Moderne GPU’er tilbyder højere effektivitet i manipulation af billedbehandling og computergrafik på grund af deres parallelle struktur end Central Processing Units (CPU’er). En GPU er indlejret på bundkortet eller placeret på en pc’s videokort eller CPU-stik.

Cloud Graphics Units (GPU’er) er computerforekomster med robust hardwareacceleration, der er nyttig til at køre applikationer til at håndtere massive AI og deep learning-arbejdsbelastninger i skyen. Det kræver ikke, at du installerer en fysisk GPU på din enhed.

Nogle populære GPU’er er NVIDIA, AMD, Radeon, GeForce og mere.

GPU’er bruges i:

- Mobiltelefoner

- Spillekonsoller

- Arbejdsstationer

- Indlejrede systemer

- Personlige computere

Hvad bruges GPU’er til:

Her er nogle eksempler på brug af GPU’er:

- I AI og ML til billedgenkendelse

- Beregninger til 3D computergrafik og CAD-tegninger

- Teksturkortlægning og gengivelse af polygoner

- Geometriske beregninger som translationer og rotationer af toppunkter til koordinatsystemer

- Understøtter programmerbare shaders til at manipulere teksturer og hjørner

- GPU-accelereret videokodning, afkodning og streaming

- Grafikrigt spil og skyspil

- Matematisk modellering, analyse og dyb læring i stor skala, der kræver parallelle bearbejdningskapaciteter af generelle GPU’er.

- Videoredigering, grafisk design og indholdsskabelse

Hvad er fordelene ved Cloud GPU’er? 👍

De vigtigste fordele ved at bruge Cloud GPU’er er:

Meget skalerbar

Hvis du ønsker at udvide din organisation, vil dens arbejdsbyrde med tiden stige. Du skal bruge en GPU, der kan skaleres med din øgede arbejdsbyrde. Cloud GPU’er kan hjælpe dig med at gøre det ved at lade dig tilføje flere GPU’er nemt uden besvær, så du kan imødekomme dine øgede arbejdsbyrder. Hvis du omvendt vil nedskalere, er det også hurtigt muligt.

Minimerer omkostningerne

I stedet for at købe fysiske GPU’er med høj effekt, der koster utroligt højt, kan du gå med cloud GPU’er til leje, der er tilgængelig til en lavere pris på timebasis. Du vil blive opkrævet for det antal timer, du har brugt cloud GPU’erne, i modsætning til de fysiske, der ville have kostet dig meget, selvom du ikke bruger dem meget.

Rydder lokale ressourcer

Cloud GPU’er bruger ikke dine lokale ressourcer, i modsætning til fysiske GPU’er, der optager en betydelig mængde plads på din computer. For ikke at nævne, hvis du kører en storstilet ML-model eller gengiver en opgave, gør det din computer langsommere.

Til dette kan du overveje at outsource beregningskraften til skyen uden at stresse din computer og bruge den med lethed. Brug bare computeren til at styre alting i stedet for at give den hele presset til at håndtere arbejdsbyrden og beregningsopgaver.

Sparer tid

Cloud GPU’er giver designere fleksibiliteten ved hurtig iteration med hurtigere gengivelsestider. Du kan spare en masse tid ved at udføre en opgave på få minutter, der plejede at tage timer eller dage. Derfor vil dit teams produktivitet øges betydeligt, så du kan investere tid i innovation i stedet for gengivelse eller beregninger.

Hvordan hjælper GPU’er med Deep Learning og AI?

Dyb læring er grundlaget for kunstig intelligens. Det er en avanceret ML-teknik, der lægger vægt på repræsentativ læring ved hjælp af kunstige neurale netværk (ANN’er). Deep learning-modellen bruges til at behandle store datasæt eller meget beregningsmæssige processer.

Så hvordan kommer GPU’er ind i billedet?

GPU’er er designet til at udføre parallelle beregninger eller flere beregninger samtidigt. GPU’er kan udnytte mulighederne for deep learning-modellen til at fremskynde store beregningsopgaver.

Da GPU’er har mange kerner, tilbyder de fremragende parallelbehandlingsberegninger. Derudover har de højere hukommelsesbåndbredde til at rumme enorme mængder data til deep learning-systemer. Derfor bruges de i vid udstrækning til træning af AI-modeller, gengivelse af CAD-modeller, til at spille grafikrige videospil og mere.

Desuden, hvis du vil eksperimentere med flere algoritmer samtidigt, kan du køre adskillige GPU’er separat. Det letter forskellige processer på separate GPU’er uden parallelitet. Til dette kan du bruge flere GPU’er på tværs af forskellige fysiske maskiner eller i en enkelt maskine til at distribuere tunge datamodeller.

Sådan kommer du i gang med Cloud GPU

At komme i gang med cloud-GPU’er er ikke raketvidenskab. Faktisk er alt nemt og hurtigt, hvis du kan forstå det grundlæggende. Først og fremmest skal du vælge en cloud GPU-udbyder, for eksempel Google Cloud Platform (GCP).

Tilmeld dig derefter GCP. Her kan du benytte dig af alle de standardfordele, der følger med, såsom cloud-funktioner, lagringsmuligheder, databasestyring, integration med applikationer og mere. Du kan også bruge deres Google Colboratory, der fungerer som Jupyter Notebook, til at bruge én GPU GRATIS. Endelig kan du begynde at gengive GPU’er til din brugssag.

Så lad os se på forskellige muligheder, du har for cloud-GPU’er til at håndtere AI og massive arbejdsbelastninger.

Linode

Linode tilbyder on-demand GPU’er til parallel bearbejdning af arbejdsbelastninger som videobehandling, videnskabelig databehandling, machine learning, AI og mere. Det giver GPU-optimerede VM’er accelereret af NVIDIA Quadro RTX 6000, Tensor, RT-kerner og udnytter CUDA-kraften til at udføre ray-tracing-arbejdsbelastninger, deep learning og kompleks behandling.

Vend din kapitaludgift til driftsudgiften ved at tage adgangen fra Linode GPU for at udnytte GPU-kraften og drage fordel af skyens reelle værdiforslag. Plus, Linode giver dig mulighed for at koncentrere dig om kernekompetencerne i stedet for at bekymre dig om hardwaren.

Linode GPU’er fjerner barrieren for at udnytte dem til komplekse brugssager som videostreaming, AI og maskinlæring. Derudover vil du få op til 4 kort for hver instans, afhængigt af de hestekræfter, du har brug for til den forventede arbejdsbelastning.

Quadro RTX 6000 har 4.608 CUDA-kerner, 576 Tensor-kerner, 72 RT-kerner, 24 GB GDDR6 GPU-hukommelse, 84T RTX-OPS, 10 Giga Rays/sek Rays Cast og FP32-ydelse på 16,3 TFLOPs.

Prisen for den dedikerede plus RTX6000 GPU-plan er $1,5/time.

Paperspace CORE

Overlad din organisatoriske arbejdsgang med næste generations accelererede computerinfrastruktur ved Paperspace CORE. Det tilbyder en brugervenlig og ligetil grænseflade til at give enkel onboarding, samarbejdsværktøjer og desktop-apps til Mac, Linux og Windows. Brug den til at køre applikationer med høj efterspørgsel gennem ubegrænset computerkraft.

CORE giver et lynhurtigt netværk, øjeblikkelig klargøring, 3D-app-understøttelse og fuld API til programmatisk adgang. Få et komplet overblik over din infrastruktur med en ubesværet og intuitiv GUI på et enkelt sted. Plus, få fremragende kontrol med CORE’s administrationsgrænseflade med robuste værktøjer og giver dig mulighed for at filtrere, sortere, forbinde eller oprette maskiner, netværk og brugere.

COREs kraftfulde administrationskonsol udfører opgaver hurtigt som at tilføje Active Directory-integration eller VPN. Du kan også nemt administrere de komplekse netværkskonfigurationer og fuldføre tingene hurtigere med få klik.

Desuden vil du finde mange integrationer, som er valgfrie, men nyttige i dit arbejde. Få avancerede sikkerhedsfunktioner, delte drev og mere med denne cloud GPU-platform. Nyd de billige GPU’er ved at få uddannelsesrabatter, faktureringsadvarsler, faktureret for et sekund osv.

Tilføj enkelhed og hastighed til arbejdsgangen til en startpris på $0,07/time.

Google Cloud GPU’er

Få højtydende GPU’er til videnskabelig databehandling, 3D-visualisering og maskinlæring med Google Cloud GPU’er. Det kan hjælpe med at fremskynde HPC, vælge en bred vifte af GPU’er for at matche prispunkter og ydeevne og minimere din arbejdsbyrde med maskintilpasninger og fleksible priser.

De tilbyder også mange GPU’er som NVIDIA K80, P4, V100, A100, T4 og P100. Plus, Google Cloud GPU’er balancerer hukommelsen, processoren, højtydende disk og op til 8 GPU’er i hver instans for den individuelle arbejdsbyrde.

Desuden får du adgang til brancheførende netværk, dataanalyse og opbevaring. GPU-enheder er kun tilgængelige i bestemte zoner på tværs af nogle regioner. Prisen vil afhænge af regionen, den GPU du vælger, og typen af maskine. Du kan beregne din pris ved at definere dine krav i Google Cloud Pricing Calculator.

Alternativt kan du gå efter disse løsninger:

Elastisk GPU-service

Elastisk GPU-service (EGS) giver parallelle og kraftfulde computerfunktioner med GPU-teknologi. Den er ideel til mange scenarier som videobehandling, visualisering, videnskabelig databehandling og deep learning. EGS bruger flere GPU’er såsom NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 og AMD FirePro S7150.

Du får fordele som online deep learning-inferenstjenester og træning, indholdsidentifikation, billed- og stemmegenkendelse, HD-mediekodning, videokonferencer, kildefilmreparation og 4K/8K HD live.

Få desuden muligheder som videogengivelse, beregningsfinansiering, klimaforudsigelse, kollisionssimulering, genteknologi, ikke-lineær redigering, fjernundervisningsapplikationer og ingeniørdesign.

- GA1-instansen giver op til 4 AMD FirePro S7150 GPU’er, 160 GB hukommelse og 56 vCPU’er. Den indeholder 8192 kerner og 32 GB GPU-hukommelse, der fungerer parallelt og leverer 15 TFLOPS enkeltpræcision og en TFLOPS dobbeltpræcision.

- GN4-instansen giver op til 2 NVIDIA Tesla M40 GPU’er, 96 GB hukommelse og 56 vCPU’er. Den indeholder 6000 kerner og 24 GB GPU-hukommelse, der leverer 14 TFLOPS af enkeltpræcision. På samme måde vil du finde mange forekomster såsom GN5, GN5i og GN6.

- EGS understøtter 25 Gbit/s og op til 2.000.000 PPS netværksbåndbredde internt for at give maksimal netværksydelse, der kræves af beregningsknuderne. Den har en højhastigheds lokal cache, der er forbundet med SSD eller ultra cloud diske.

- Højtydende NVMe-drev håndterer 230.000 IOPS med I/O-latens på 200 s og giver 1900 Mbit/s læsebåndbredde og 1100 Mbit/s skrivebåndbredde.

Du kan vælge mellem forskellige købsmuligheder baseret på dine behov for at få ressourcerne og kun betale for det.

Azure N-serien

Azure N-serien af Azure Virtual Machines (VM’er) har GPU-funktioner. GPU’er er ideelle til grafik og computerintensive arbejdsbelastninger, og hjælper brugerne med at geare innovation gennem forskellige scenarier som deep learning, forudsigende analyser og fjernvisualisering.

Forskellige N-serier har separate tilbud til specifikke arbejdsbelastninger.

- NC-serien fokuserer på højtydende maskinlæring og computerarbejdsbelastninger. Den seneste version er NCsv3, som har NVIDIAs NVIDIAs Tesla V100 GPU.

- ND-serien fokuserer på inferens og træningsscenarier grundlæggende for dyb læring. Den bruger NVIDIA Tesla P40 GPU’er. Den seneste version er NDv2, der har NVIDIA Tesla V100 GPU’er.

- NV-serien fokuserer på fjernvisualisering og andre intensive applikationsbelastninger understøttet af NVIDIA Tesla M60 GPU.

- NC, NCsv3, ND’erne og NCsv2 VM’erne tilbyder InfiniBand-sammenkobling, der muliggør opskalering. Her får du fordelene som deep learning, grafikgengivelse, videoredigering, spil osv.

IBM Cloud

IBM Cloud giver dig fleksibilitet, kraft og mange GPU-muligheder. Da GPU er den ekstra hjernekraft, som en CPU mangler, hjælper IBM Cloud dig med at få direkte adgang til det mere tilgængelige udvalg af serveren til problemfri integration med IBM Cloud-arkitekturen, applikationerne og API’erne sammen med et distribueret netværk af datacentrene globalt.

- Du får bare metal-server GPU-muligheder såsom Intel Xeon 4210, NVIDIA T4 grafikkort, 20 kerner, 32 GB RAM, 2,20 GHz og 20 TB båndbredde. På samme måde får du også muligheder for Intel Xeon 5218 og Intel Xeon 6248.

- Til virtuelle servere får du AC1.8×60 som har otte vCPU, 60 GB RAM, 1 x P100 GPU. Her får du også mulighederne AC2.8×60 og AC2.8×60.

Få den bare metal-server-GPU til en startpris på $819/måned og den virtuelle server-GPU til en startpris på $1,95/time.

AWS og NVIDIA

AWS og NVIDIA har samarbejdet om at levere omkostningseffektive, fleksible og kraftfulde GPU-baserede løsninger løbende. Det inkluderer NVIDIA GPU-drevne Amazon EC2-instanser og tjenester som AWS IoT Greengrass, der implementeres med NVIDIA Jetson Nano-moduler.

Brugere bruger AWS og NVIDIA til virtuelle arbejdsstationer, maskinlæring (ML), IoT-tjenester og højtydende computere. Amazon EC2-forekomster, hvor NVIDIA GPU’er er ansvarlige for at levere skalerbar ydeevne. Brug desuden AWS IoT Greengrass til at udvide AWS-skytjenesterne til de NVIDIA-baserede edge-enheder.

NVIDIA A100 Tensor Core GPU’erne driver Amazon EC2 P4d-instanser for at levere brancheførende netværk med lav latency og høj gennemstrømning. Tilsvarende vil du finde mange andre tilfælde for specifikke scenarier såsom Amazon EC2 P3, Amazon EC2 G4 osv.

Ansøg om den GRATIS prøveperiode og oplev kraften fra GPU’en til kanten fra skyen.

OVHcloud

OVHcloud leverer cloud-servere, der er designet til at behandle massive parallelle arbejdsbelastninger. GPU’erne har mange instanser integreret med NVIDIA Tesla V100 grafiske processorer for at imødekomme deep learning og maskinlæringsbehov.

De hjælper med at accelerere databehandling inden for grafisk databehandling samt kunstig intelligens. OVH samarbejder med NVIDIA for at tilbyde den bedste GPU-accelererede platform til højtydende computing, AI og deep learning.

Brug den mest ligetil måde til at implementere og vedligeholde GPU-accelererede containere gennem et komplet katalog. Den leverer et af fire kort til instanserne direkte via PCI Passthrough uden noget virtualiseringslag for at dedikere alle kræfterne til din brug.

OVHclouds tjenester og infrastrukturer er ISO/IEC 27017, 27001, 27701 og 27018 certificerede. Certificeringerne indikerer, at OVHcloud har et informationssikkerhedsstyringssystem (ISMS) til at styre sårbarheder, implementere forretningskontinuitet, styre risici og implementere et privatlivsinformationsstyringssystem (PIMS).

Desuden har NVIDIA Tesla V100 mange værdifulde funktioner såsom PCIe 32 GB/s, 16 GB HBM2 kapacitet, 900 GB/s båndbredde, double precision-7 teraFLOPs, single precision-14 teraFLOPs og deep learning-112 teraFLOPs.

Lambda GPU

Træn deep learning, ML og AI-modeller med Lambda GPU Cloud og skaler fra en maskine til det samlede antal VM’er i løbet af nogle klik. Få forudinstallerede store frameworks og den seneste version af lambda Stack, der inkluderer CUDA-drivere og deep learning frameworks.

Få adgang til det dedikerede Jupyter Notebook-udviklingsmiljø for hver maskine hurtigt fra dashboardet. Brug SSH direkte med en af SSH-tasterne eller opret forbindelse via webterminalen i skyens dashboard for direkte adgang.

Hver instans understøtter maksimalt 10 Gbps inter-node båndbredde, der muliggør spredt træning med rammer som Horovod. Du kan også spare tid i modeloptimering ved at skalere til antallet af GPU’er på enkelte eller mange forekomster.

Med Lambda GPU Cloud kan du endda spare 50 % på databehandling, reducere cloud TCO og vil aldrig få flerårige forpligtelser. Brug en enkelt RTX 6000 GPU med seks VCPU’er, 46 GiB RAM, 658 GiB midlertidig lagerplads til kun $1,25/time. Vælg mellem mange instanser i henhold til dine krav for at få en on-demand-pris til dit brug.

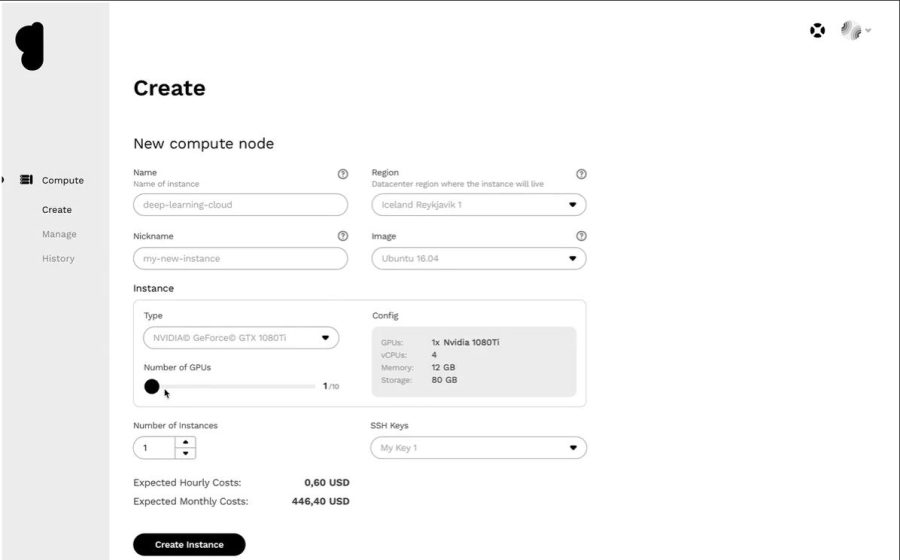

Genesis Cloud

Få en effektiv cloud GPU-platform til en meget overkommelig pris fra Genesis Cloud. De har adgang til mange effektive datacentre over hele kloden, som de samarbejder med for at tilbyde en bred vifte af applikationer.

Alle tjenester er sikre, skalerbare, robuste og automatiserede. Genesis Cloud giver ubegrænset GPU-beregningskraft til visuelle effekter, maskinlæring, omkodning eller lagring, Big Data-analyse og mange flere.

Genesis Cloud tilbyder mange rige funktioner GRATIS, såsom snapshots til at gemme dit arbejde, sikkerhedsgrupper for netværkstrafikken, lagervolumener til de store datasæt, FastAI, PyTorch, prækonfigurerede billeder og en offentlig API til TensorFlow.

Den har NVIDIA og AMD GPU’er af forskellige typer. Træn desuden det neurale netværk eller generer animerede film ved at udnytte kraften i GPU-databehandling. Deres datacentre kører med 100 % vedvarende energi fra geotermiske kilder til lavere kulstofemissioner.

Deres priser er 85 % mindre end andre udbydere, da du betaler for trin på minutniveau. Du kan også spare mere med langsigtede og ufravigelige rabatter.

Konklusion 👩🏫

Cloud GPU’er er designet til at tilbyde utrolig ydeevne, hastighed, skalering, plads og bekvemmelighed. Overvej derfor at vælge din foretrukne cloud GPU-platform med out-of-the-box-funktioner for at accelerere dine dybe læringsmodeller og nemt håndtere AI-arbejdsbelastninger.