Web unlockers er avancerede web-skrabere, der er effektive til at indsamle data fra forskellige websteder og kommer med moderne funktioner til at hjælpe dig med at forbedre din virksomhed.

Forretningsdata er et vigtigt input til at finde værdifuld indsigt og muligheder for vækst.

Det er nødvendigt at udtrække data fra nettet for at markedsføre effektivt, hvilket er, hvad du kan opnå med web unlockers. Og hvis du udfører web-skrabning manuelt, ville det forbruge en masse tid og ressourcer.

Brug af en web unlocker kan ikke kun forbedre effektiviteten, produktiviteten og nøjagtigheden, men også guide din virksomhed mod succes ved at automatisere dataudtræksopgaver.

I denne artikel vil jeg diskutere vigtigheden af web-skrabning, og hvordan en web unlocker hjælper med effektiv dataudtræk.

Indholdsfortegnelse

Hvad er Web Scraping?

Webskrabning er en enkel og kraftfuld proces til automatisk at indsamle strukturerede data fra websteder. I modsætning til at udtrække data manuelt ved at bruge mere tid, bruger web-skrabning smarte automatiseringsteknikker til at indsamle millioner, endda milliarder af data fra nettet.

De fleste af de data, du får fra internettet, er i HTML-format på en ustruktureret måde. Gennem web-skrabning kan du udtrække data og derefter konvertere dem til strukturerede data gemt i en database eller et regneark. Dette vil blive brugt yderligere i forskellige applikationer til at forstå strategien og lave din egen.

Mange virksomheder og enkeltpersoner bruger web-skrabning til at udtrække information, der er offentlig tilgængelig på websteder, for at generere indsigt og træffe intelligente beslutninger. Nogle af de vigtigste tilfælde af web-skrabning omfatter konkurrentanalyse, prisintelligens og overvågning, markedsundersøgelser, nyhedsovervågning og leadgenerering.

Udfordringer ved webskrabning

Selvom web-skrabning er en vigtig teknologi til at udtrække og indsamle specifikke data, har det nogle udfordringer.

Bots

Websteder kan vælge, om de vil tillade web-scaper-bots til skrabeformål eller ej. Der er mange websteder, der ikke tillader web-skrabeprocessen, da bots for det meste dræner serverressourcer, mens de skraber data fra webstedet. Således påvirker det indirekte webstedets ydeevne.

Hyppige strukturelle ændringer

For at opretholde gode fremskridt i UI/UX og tilføje flere funktioner, gennemgår websteder regelmæssigt strukturelle ændringer. Webskrabere er skrevet specifikt med hensyn til websidens kodeelementer på opsætningstidspunktet. Hyppige ændringer komplicerer tingene, hvilket giver skraberne en slags hård tid.

Selvom enhver strukturel ændring ikke påvirker opsætningen, kan nogle føre til datatab. Det er også svært for webskrabere at vedligeholde en fane med ændringer for at forblive aktiv, når en bruger udtrækker data.

Captchas

Det primære mål med captchas er at skelne mellem mennesker og bots ved at vise en form for logiske problemer. Så den grundlæggende opgave er at holde uønsket spam væk. I nærvær af en captcha vil grundlæggende scripts, der bruges af skrabere, ikke fungere.

Forbud

Når en webskraberbot sender parallelle anmodninger flere gange eller unaturligt laver et højt antal anmodninger, er der en chance for, at botten krydser den tynde grænse mellem uetisk og etisk webskrabning og bliver markeret. Webskraber skal være smart nok til at støde på sådanne problemer ved at forblive på den rigtige side af skrabereglerne og opnå, hvad de ønsker.

Dataskrabning i realtid

Dataskrabning i realtid er vigtig for mange virksomheder for at få afgørende indsigt og træffe bedre beslutninger. Fra svingende aktiekurser til skiftende produktpriser hjælper dataskrabning med at skaffe kapital til din virksomhed.

At erhverve store datasæt er overhead, og at træffe beslutninger baseret på disse data kan være en udfordring. Således bruger realtidswebskrabere REST API til at overvåge dynamiske tilgængelige data og skrabe dem. Men det er stadig en udfordring. Skødesløs dataophugning kan forårsage skade på webstedet og internettet og påvirke din virksomhed negativt.

Honeypot fælder

Webstedsejere sætter en honeypot-fælde på sider for at fælde parsere. Fælder kan være links, som parsere kan se, men som almindelige mennesker ikke kan. Når en parser kommer i fælden, bruger webstedet de oplysninger, det modtager, til at blokere scraper-bots.

Login krav

Nogle gange skal du logge ind på siden for at få oplysningerne. Når du har sendt dine loginoplysninger, tilføjer browseren en cookieværdi til dine anmodninger, der kører på et andet websted. Herigennem kan hjemmesiden vide, at du er den samme person, som loggede ind tidligere og muligvis blokerer dig.

Hvordan kan Web Unlocker hjælpe?

En web unlocker er en avanceret version af web scraper. Det hjælper digitale marketingfolk, dataanalytikere og internetforskere med at få adgang til websteder (selv blokerede) til deres forskningsformål. Det låser hele internettet op for dig og omgår blokeringer, banes, captchas og begrænsninger, mens den automatiserer web-skrabningsprocessen.

Adgang til offentlige data er lovligt i henhold til forskellige regler. Og web unlocker blev udviklet som en løsning til at fjerne blokeringen af skrabestien. Med en web unlocker skal du bare sende anmodninger uden at bekymre dig om fælder eller blokeringer.

En web unlocker aktiverer følgende:

- Den bruger automatisk en privat IP-adresse eller en datacenterproxy til at omgå botdetekteringssystemer

- Lader dig fremstå som en almindelig bruger af websteder

- Løser login problemer

- Får adgang til lokaliseret indhold over hele verden

- Redder dig fra fælder

- Styrer fuld cyklus IP-rotationsstyring

- Tilpasser fingeraftryk i realtid

- Låser op og løser captcha-relaterede problemer

- Får adgang til geo-begrænsede websteder til udtrækning af data

- Justerer sig selv for at forblive uopdaget

- Maskinlæringsalgoritmerne i Web Unlocker gør dataudtræk lettere

- Det giver dig mulighed for at bruge funktionen til at skrabe API’er.

- Du kan forblive uopdagelig ved hjælp af et udvidet lager af browsing-cookies, emulerede enheder og HTTP-header-anmodninger

- Du kan lave ubegrænsede anmodninger for at få de data, du har brug for

Hvordan fungerer en Web Unlocker?

For at udtrække de nødvendige data, er det nødvendigt at specificere det, så en web unlocker udtrækker dataene præcist og hurtigt.

Hvis du f.eks. vil have en liste over juicepressere, der er tilgængelige på et shoppingwebsted, og ikke kundeanmeldelserne, så kan du angive dit krav om kun at få listen over juicepressere.

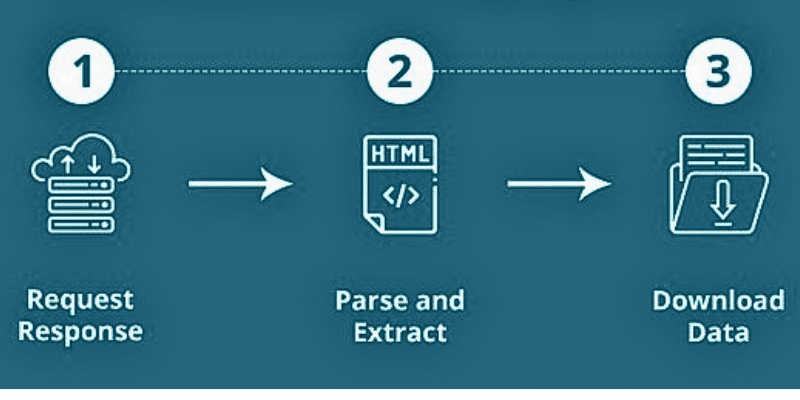

Når en web-unlocker skraber et websted, leveres URL’erne først. Den indlæser HTML-koder til lignende websteder. En avanceret skraber kan endda udtrække alle Javascript- og CSS-elementer. Dernæst konverterer skraberen dataene i HTML-koden til et enkelt og forståeligt format.

Kilde: Quora

Kilde: Quora

For det meste er outputformatet i form af en CSV-fil eller et Excel-regneark. Dataene kan også gemmes i andre formater, herunder en JSON-fil.

Webskrabning består af to dele:

- Crawleren er en AI-algoritme, der gennemser internettet for at søge efter bestemte oplysninger, der kræves af links på tværs af nettet.

- En skraber er et specifikt værktøj designet til at indsamle data fra hjemmesiden. Designet varierer med hensyn til kompleksiteten og omfanget af dit projekt.

På denne måde kan den præcist og hurtigt udtrække data.

Vigtigheden af en Web Unlocker

Uanset om du er ny eller er i vækst, hjælper dataudtræk dig med at øge din virksomhedsvækst med 10x. Der er mange grunde til, at udviklere, analytikere og virksomheder elsker at bruge en web-unlocker over selvadministrerede proxyer og captcha-håndtering med hensyn til funktioner og muligheder. Lad os finde ud af, hvordan web-skrabning med en web-unlocker gavner virksomheder.

Forenkling af dataudtræk

Med moderne teknologier som web unlockers kan du forenkle processen med dataudtræk. Det giver enhver mulighed for nemt at udtrække data i stor skala. Derudover kan du få adgang til bots, der giver dig mulighed for at indsamle data i enhver skala.

Innovation med lynets hast

Crawling og scraping giver virksomheder mulighed for at innovere og skabe nye produkter hurtigere. Mange virksomheder vokser ved at indsamle og bruge data fra flere kilder. Med web-skrabning kan du forbedre dit værditilbud. Derudover hjælper det dig med at teste og eksekvere nye ideer med udtrukket data fra hjemmesider.

Førende generation

Ved hjælp af en web unlocker kan du ubesværet få adgang til konkurrenternes forretningsdata. Dette hjælper dig også med at bygge automatiserede salgsmaskiner. Du kan søge og samle data afhængigt af den kvalitet og det nøjagtighedsniveau, du har brug for. Når du har de nødvendige data, kan du generere leads og opretholde vækst.

Marketing Automation

Dataskrabning er direkte forbundet med marketingautomatisering. Lad os sige, at du får øje på din konkurrents profil på Instagram med 18k+ følgere. Men hvis dit produkt er bedre, og brugerne får kendskab til det, kan de nemt skifte. Til dette har du brug for bedre markedsføring.

For at gøre det kan du skrabe data, der indeholder følgerlisten, og følge dem og DM dem. Du kan også gøre dette på Twitter, Facebook osv. Derudover kan du gøre det samme for konkurrerende hjemmesider. Dette vil hjælpe dig med at vokse hurtigere på markedet ved at vide, hvad din kunde har brug for og give dem præcis, hvad de ønsker.

Brand overvågning

Det grundlæggende trin, som de fleste kunder følger, er at tjekke anmeldelser, før de køber. Virksomheder skal anbefale produkter efter deres behov og få dem til at tro, at de træffer det rigtige valg. Med en web unlocker kan du forstå dine kunder og tilbyde bedre tilbud.

Desuden kan du overvåge sociale netværk og kombinere dem med sentimentanalyse for at reagere på og belønne brugere hurtigt.

Markedsanalyse

Kvalitet frem for kvantitet er det, der betyder mest i dagens konkurrenceprægede verden. I stedet for store mængder data har du brug for smarte data.

Hvis du for eksempel sælger reservedele til maskiner, skal du angive formålet med at købe delene. Her skal du blot indsamle data fra specifikke hjemmesider, der også distribuerer sådanne reservedele.

Nu er det din tur til at forbedre salget ved hjælp af de data, du har udtrukket. Dette hjælper dig med at analysere markedet ganske godt og øge dit salg.

Arbejder med Machine Learning og Deep Learning

Du har brug for en stor datamængde for at træne dine maskiner til at bygge en model efter inputtet. Data er dit primære input, når du vil have din maskine til at udføre arbejdet.

Uanset om du vil forudsige aktiemarkedet eller strategien for dine konkurrenters produkters salg, er det et godt skridt mod succes at udtrække data fra hjemmesiderne ved at bruge ML og DL og angive din årsag.

SEO

SEO-eksperter bruger forskellige værktøjer til at finde det rigtige søgeord til indholdet. Det bliver nemmere med dataudtræk med en web unlocker. SEO-eksperter udfører dataudtræk om din konkurrents SEO-bestræbelser for at vide, hvordan deres indhold klarer sig. Dette hjælper dig også med at forstå, hvilke ændringer du skal gennemføre for at forbedre din SEO.

End-to-end test

Hvis du er udvikler, hjælper udtrækning af data fra forskellige kilder med at forbedre din testindsats og sparer tid i processer, der ikke giver resultater.

Web Unlockers

Her er nogle af de bedste weboplåsere, som du kan bruge og begynde at udtrække de nødvendige data.

#1. Lyse data

Bright Data tilbyder et web unlocker-værktøj, der giver dig mulighed for at overvinde webstedsblokeringer i realtid. Den automatiserede weboplåsning tackler browserbrugeragenter, captcha-løsning og cookies. Det skraber også data fra målwebsteder konsekvent ved hjælp af IP-adresserotation.

Sådan bruger du denne weboplåser:

- Vælg blot det websted, du vil låse op

- Foretag en ligetil proxyanmodning sammen med webstedets URL, og

- Få de data, du søger

Med Bright Datas Web Unlocker bliver du ikke blokeret igen. Det udvikler automatisk nye metoder til at holde websteder åbne for dataudtræk til enhver tid. Det administrerer også IP-brugshastigheder, så du aldrig beder om nogen mængde data fra én IP. Derudover emulerer den de enheder, som servere ønsker at se.

Du får automatisk brugeremulering. Dette inkluderer at klikke på målrettede hjemmesidelinks, lave menneskelige musebevægelser og mere. Web Unlocker sikrer, at målwebstedet vil se, at du kommer fra et populært websted. Desuden identificerer den honningkrukker og undgår fælden.

#2. Oxylab

Få blokfri dataskrabning i stor skala med Oxylabs Web Unblocker og få adgang til offentlige data fra vanskelige websteder ved kun at betale for vellykket dataudtræk. Du får ML-drevet administration af proxyer, dynamisk browser-fingeraftryk, funktionalitet for automatisk genforsøg og ML-drevet svargenkendelse.

Oxylabs sikrer, at din IP-adresse aldrig blokeres igen med en AI-drevet proxy-løsning. Det omgår anti-bot-systemer med en høj succesrate og sparer ressourcer. Dens dynamiske fingeraftryk giver dig mulighed for at se indhold som en rigtig bruger.

Oxylabs Web Unblocker vælger de rigtige cookies, overskrifter, JavaScript-gengivelse og mere til dig, så du kan få pålidelige resultater og menneskelignende browsing og aldrig stå over for nogen captcha-relaterede problemer. Uanset din placering kan du få adgang til lokaliseret indhold hvor som helst på jorden.

Du vil finde mere end 102M etisk genererede proxy-puljer. Det giver dig mulighed for at indsamle offentlige data uden besvær. Derudover får du sessionskontrol, et praktisk dashboard, nem skalering, JavaScript-gengivelse og mere.

Konklusion

Webskrabning er en fordel for virksomheder at indsamle vigtige forretningsdata og bruge dem til at forbedre deres forretning. Manuel web-skrabning er trættende og tidskrævende, og det er derfor, moderne organisationer bruger web-skrabningsværktøjer til at automatisere dataudtræksopgaver.

Web-skrabeværktøjer kommer dog også med visse udfordringer, efterhånden som teknologien udvikler sig, og websteder er ved at finde ud af, hvordan de kan opdage og blokere mindre kraftfulde webskrabere. Til dette kan en web unlocker hjælpe, da det er en avanceret form for en web-skraber, der kan omgå restriktioner, blokeringer og baner. Det vil hjælpe med at forbedre effektiviteten og effektiviteten af web-skrabeprocesser.

Så hvis du leder efter et kraftfuldt webskrabeværktøj, så overvej at bruge en weboplåser. Ovennævnte er nogle af de bedste web unlockers tilgængelige på markedet, som du kan vælge baseret på dine forretningskrav.

Du kan også udforske nogle af de bedste skrabere på sociale medier for at udtrække værdifulde data.