Algoritmisk bias kan påvirke forskellige aspekter af vores liv, lige fra at få onlineindholdsanbefalinger til at finde job og træffe økonomiske beslutninger.

Bias ligger i menneskets natur. Forskellige mennesker har forskellige køn, racer, opdragelser, uddannelsesbaggrunde, kulturer, overbevisninger, erfaringer og så videre.

Deres meninger, tanker, kan lide og antipatier og præferencer varierer således fra hinanden. De kan udvikle visse skævheder over for eller imod bestemte kategorier.

Maskiner er ikke anderledes. Disse kan også se mennesker, ting og begivenheder anderledes på grund af skævheder introduceret i deres algoritmer. På grund af disse skævheder kan AI- og ML-systemer producere uretfærdige resultater, hvilket hæmmer folk på mange måder.

I denne artikel vil jeg diskutere, hvad algoritmiske skævheder er, deres typer, og hvordan man opdager og reducerer dem for at øge retfærdighed i resultater.

Lad os begynde!

Indholdsfortegnelse

Hvad er algoritmiske skævheder?

En algoritmisk bias er ML- og AI-algoritmernes tendens til at afspejle menneskelignende skævheder og generere uretfærdige output. Forstyrrelserne kan være baseret på køn, alder, race, religion, etnicitet, kultur og så videre.

I forbindelse med kunstig intelligens og maskinlæring er algoritmiske skævheder systematiske, gentagelige fejl introduceret i et system, der producerer urimelige resultater.

Forstyrrelser i algoritmer kan opstå på grund af mange årsager, såsom beslutninger relateret til, hvordan data indsamles, vælges, kodes eller bruges til træning af algoritmen, den påtænkte brug, algoritmens design osv.

Eksempel: Du kan observere algoritmisk skævhed i et søgemaskineresultat, hvilket fører til krænkelser af privatlivets fred, sociale skævheder osv.

Der er mange tilfælde af algoritmiske skævheder på områder som valgresultater, spredning af hadefulde ytringer online, sundhedsvæsen, strafferet, rekruttering osv. Dette forværrer eksisterende skævheder i køn, race, økonomi og samfund.

Typer af algoritmiske skævheder

#1. Databias

Databias opstår, når de data, der kræves til træning af en AI-model, ikke korrekt repræsenterer scenarier eller populationer i den virkelige verden. Dette kan resultere i ubalancerede eller skæve datasæt.

Kilde: TELUS International

Kilde: TELUS International

Eksempel: Antag, at en softwareløsning til ansigtsgenkendelse primært trænes på den hvide befolkning. Så den kan fungere dårligt, når den får til opgave at genkende personer med mørkere hudtoner, hvilket påvirker dem.

#2. Måling Bias

Denne skævhed kan opstå på grund af en fejl i måle- eller dataindsamlingsprocessen.

Eksempel: Hvis du træner en diagnostisk algoritme i sundhedsvæsenet til at opdage en sygdom baseret på nogle målinger som tidligere lægebesøg, kan det sløre dømmekraften og forårsage skævhed, mens den overser faktiske symptomer.

#3. Model Bias

Modelbias opstår under udformningen af algoritmen eller AI-modellen.

Eksempel: Antag, at et AI-system har en algoritme, der er designet til at maksimere profitten uanset hvordan; det kan ende med at prioritere økonomiske gevinster på bekostning af forretningsetik, sikkerhed, retfærdighed osv.

#4. Evaluering Bias

Evalueringsbias kan opstå, når faktorerne eller kriterierne for evaluering af et AI-systems ydeevne er skæve.

Kilde: Ryd anmeldelse

Kilde: Ryd anmeldelse

Eksempel: Hvis et AI-system til præstationsevaluering bruger standardtests, der favoriserer en bestemt kategori af medarbejdere i en virksomhed, kan det fremme uligheder.

#5. Rapportering Bias

Rapporteringsbias kan forekomme, når træningsdatasættet mangler en nøjagtig afspejling af virkeligheden i dets hændelsesfrekvens.

Eksempel: Hvis et AI-sikkerhedsværktøj ikke fungerer godt i en bestemt kategori, kan det markere hele kategorien som mistænkelig.

Det betyder, at det datasæt, som systemet er blevet trænet i, markerede hver historisk hændelse relateret til den pågældende kategori som usikker på grund af den højere frekvens af hændelser.

#6. Udvælgelse Bias

Udvælgelsesbias opstår, når træningsdataene vælges uden ordentlig randomisering eller ikke repræsenterer den samlede population godt.

Eksempel: Hvis et ansigtsgenkendelsesværktøj trænes på begrænsede data, kan det begynde at udvise en vis forskelsbehandling af data, som det møder mindre, såsom at identificere farvede kvinder i politik end mænds og lysere personer i politik.

#7. Implicit bias

Implicit bias opstår, når AI-algoritmen gør antagelser baseret på visse personlige erfaringer, som måske ikke gælder for bredere kategorier eller mennesker eksplicit.

Eksempel: Hvis en dataforsker, der designer en AI-algoritme, personligt mener, at kvinder primært kan lide pink og ikke blå eller sort, kan systemet anbefale produkter i overensstemmelse hermed, hvilket ikke gælder for alle kvinder. Mange elsker blå eller sort.

#8. Gruppetilskrivningsbias

Denne bias kan ske, når algoritmedesignerne anvender ting, der er beregnet til bestemte individer, til en komplet gruppe, uanset om disse personer er en del af gruppen eller ej. Gruppetilskrivningsbias er almindelig i rekrutterings- og optagelsesværktøjer.

Eksempel: Et optagelsesværktøj kan favorisere kandidater fra en specifik skole og diskriminere mod andre elever, der ikke tilhører den pågældende skole.

#9. Historisk skævhed

Indsamling af historiske datasæt er vigtigt, når der indsamles datasæt til træning af en ML-algoritme. Men hvis du ikke er opmærksom, kan der forekomme skævhed i dine algoritmer på grund af de skævheder, der er til stede i dine historiske data.

Eksempel: Hvis du træner en AI-model med 10 års historiske data for at shortliste kandidater til tekniske stillinger, kan det begunstige mandlige ansøgere, hvis uddannelsesdataene har flere mænd end kvinder.

#10. Etiket Bias

Mens du træner ML-algoritmer, skal du muligvis mærke en masse data for at gøre det nyttigt. Processen med at mærke data kan dog variere meget, hvilket genererer inkonsekvenser og indfører skævhed i AI-systemet.

Eksempel: Antag, at du træner en AI-algoritme ved at mærke katte i billeder ved hjælp af kasser. Hvis du ikke er opmærksom, kan algoritmen muligvis ikke identificere en kat på et billede, hvis dens ansigt ikke er synligt, men kan identificere dem med katteansigter på dem.

Det betyder, at algoritmen er forudindtaget i at identificere billeder med frontvendte katte. Den kan ikke identificere katten, hvis billedet er taget fra en anden vinkel, når kroppen viser sig, men ikke ansigtet.

#11. Eksklusion Bias

Kilde: ResearchGate

Kilde: ResearchGate

Eksklusion bias opstår, når en specifik person, en gruppe af mennesker eller en kategori udelukkes utilsigtet eller bevidst under dataindsamling, hvis de menes at være irrelevante. Det sker for det meste under dataforberedelsesfasen af ML-livscyklussen på tidspunktet for rensning af data og klargøring til brug.

Eksempel: Antag, at et AI-baseret forudsigelsessystem skal bestemme et specifikt produkts popularitet i vintersæsonen baseret på dets købsrate. Så hvis en dataforsker bemærker nogle køb i oktober og fjerner disse registreringer, tror han, at de er forkerte og tager standardvarigheden fra november til januar. Men der er steder, hvor vinteren overstiger disse måneder. Så algoritmen vil være forudindtaget mod de lande, der modtager vinter fra november til januar.

Hvordan indføres skævheder i algoritmer?

Træningsdata

Hovedkilden til algoritmisk skævhed er partiske data, der bruges til træning af AI- og ML-algoritmerne. Hvis træningsdataene i sig selv har elementer af uligheder og fordomme i sig, vil algoritmen lære disse elementer og fastholde skævheder.

Design

Når udvikleren designer algoritmen, kan udvikleren bevidst eller ubevidst introducere refleksioner af personlige tanker eller præferencer i AI-systemet. Så AI-systemet vil være forudindtaget mod visse kategorier.

Beslutningstagning

Mange gange træffer dataforskere og ledere beslutninger baseret på deres personlige erfaringer, omgivelser, overbevisninger og så videre. Disse beslutninger afspejles også i algoritmer, som forårsager skævheder.

Mangel på mangfoldighed

På grund af mangel på mangfoldighed i udviklingsteamet ender teammedlemmerne med at skabe algoritmer, der ikke repræsenterer hele befolkningen. De har ikke erfaring eller eksponering for andre kulturer, baggrunde, overbevisninger, måder osv., hvorfor deres algoritmer kan være forudindtaget på en bestemt måde.

Dataforbehandling

Metoden, der bruges til at rense og behandle data, kan introducere algoritmisk bias. Derudover, hvis du ikke designer disse metoder omhyggeligt for at modvirke bias, kan det blive alvorligt i AI-modellen.

Arkitektur

Modelarkitekturen og typen af ML-algoritme, du vælger, kan også introducere bias. Nogle algoritmer tiltrækker bias mere end andre, sammen med hvordan de er designet.

Funktionsvalg

De funktioner, du valgte til at træne en AI-algoritme, er en af årsagerne til bias. Hvis du ikke vælger funktioner ved at tage hensyn til deres indvirkning på outputtets retfærdighed, kan der opstå nogle skævheder, som favoriserer nogle kategorier.

Historie og kultur

Hvis en algoritme fodres og trænes på data hentet fra historien eller visse kulturer, kan den arve skævheder som fordomme, overbevisninger, normer osv. Disse skævheder kan påvirke AI-resultater, selvom de er uretfærdige og irrelevante i nuet.

Datadrift

Data, som du bruger til at træne dine AI-algoritmer i dag, kan blive irrelevante, ubrugelige eller forældede i fremtiden. Dette kan skyldes den skiftende teknologi eller samfund. Disse datasæt kan dog stadig introducere bias og hæmme ydeevnen.

Feedback loops

Nogle AI-systemer kan ikke kun kommunikere med brugere, men også tilpasse sig deres adfærd. På denne måde kan algoritmen booste eksisterende bias. Så når brugernes personlige bias kommer ind i AI-systemet, kan det generere en forudindtaget feedback-loop.

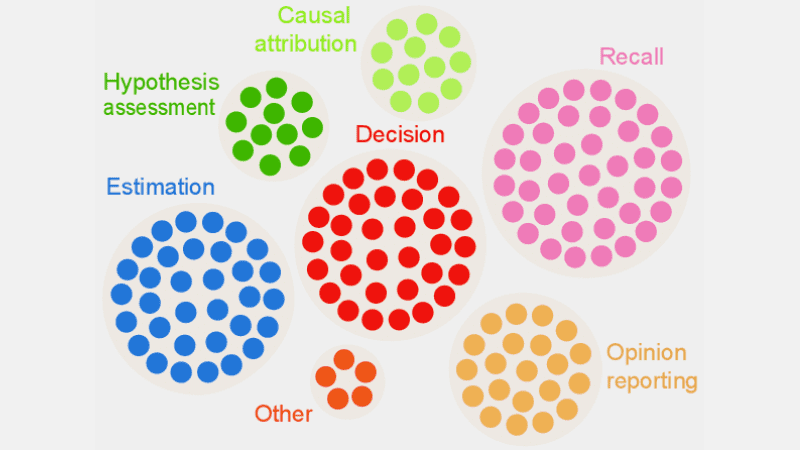

Hvordan opdager man algoritmisk bias?

Definer, hvad der er “fair”

For at opdage urimelige resultater eller skævheder i algoritmer skal du definere, hvad “fair” præcist indebærer for AI-systemet. Til dette kan du overveje faktorer som køn, alder, race, seksualitet, region, kultur osv.

Bestem målene til at beregne retfærdighed, såsom lige muligheder, forudsigelig paritet, påvirkninger osv. Når du har defineret “retfærdighed”, bliver det lettere for dig at opdage, hvad der ikke er rimeligt og løse situationen.

Audit træningsdata

Analyser dine træningsdata grundigt for at se efter ubalancer og uoverensstemmelser i at repræsentere forskellige kategorier. Du skal undersøge fordelingen af funktioner og kontrollere, om den repræsenterer demografiske oplysninger fra den virkelige verden eller ej.

Til visualisering af data kan du oprette histogrammer, varmekort, spredningsplot osv. for at fremhæve uligheder og mønstre, der ikke kan afsløres ved hjælp af kun statistisk analyse.

Udover interne revisioner kan du inddrage eksterne eksperter og revisorer til at evaluere systembias.

Mål modelydelse

For at opdage skævheder, prøv at måle ydeevnen af din AI-model for forskellige demografiske og kategorier. Det ville hjælpe, hvis du deler træningen op i forskellige grupper baseret på race, køn osv. Du kan også bruge dine fairness-metrics til at beregne forskellene i resultaterne.

Brug egnede algoritmer

Vælg algoritmer, der fremmer retfærdige resultater og kan adressere bias i træningen af en AI-model. Retfærdighedsbevidste algoritmer har til formål at forhindre bias og samtidig sikre lige forudsigelser på tværs af forskellige kategorier.

Bias Detection Software

Du kan bruge specialiserede værktøjer og biblioteker, der er retfærdighedsbevidste til at opdage skævheder. Disse værktøjer tilbyder retfærdighedsmålinger, visualiseringer, statistiske tests og mere for at opdage bias. Nogle populære er AI Fairness 360 og IBM Fairness 360.

Søg brugerfeedback

Spørg brugere og kunder om deres feedback på AI-systemet. Tilskynd dem til at give deres ærlige anmeldelser, hvis de har følt nogen form for uretfærdig behandling eller skævhed i AI-systemet. Disse data hjælper dig med at finde ud af problemer, der muligvis ikke er markeret i automatiserede værktøjer og andre registreringsprocedurer.

Sådan afbødes bias i algoritmer

Diversificer din virksomhed

At skabe mangfoldighed i din virksomhed og udviklingsteam muliggør hurtigere registrering og fjernelse af skævheder. Årsagen er, at fordomme hurtigt kan bemærkes af brugere, der er berørt af dem.

Så diversificer din virksomhed ikke kun i demografi, men også i færdigheder og ekspertise. Inkluder mennesker af forskelligt køn, identitet, race, hudfarve, økonomisk baggrund osv., samt personer med forskellig uddannelseserfaring og baggrund.

På denne måde vil du komme til at indsamle vidtgående perspektiver, oplevelser, kulturelle værdier, kan lide og antipatier osv. Dette vil hjælpe dig med at forbedre retfærdigheden af dine AI-algoritmer, hvilket reducerer skævheder.

Fremme gennemsigtighed

Vær gennemsigtig med dit team om målet, algoritmerne, datakilderne og beslutningerne vedrørende et AI-system. Dette vil gøre det muligt for brugerne at forstå, hvordan AI-systemet fungerer, og hvorfor det genererer bestemte output. Denne gennemsigtighed vil skabe tillid.

Fairness Aware Algoritmer

Brug retfærdighedsbevidste algoritmer, når du udvikler modellen for at sikre, at der genereres retfærdige resultater for forskellige kategorier. Dette bliver tydeligt, hvis du opretter AI-systemer til stærkt regulerede industrier som finans, sundhedspleje osv.

Evaluer modellens ydeevne

Test dine modeller for at undersøge AI’ens ydeevne på tværs af forskellige grupper og undergrupper. Det hjælper dig med at forstå problemer, der ikke er synlige i de samlede metrics. Du kan også simulere forskellige scenarier for at kontrollere deres ydeevne i disse scenarier, herunder komplekse.

Følg etiske retningslinjer

Formuler nogle etiske retningslinjer for udvikling af AI-systemer, der respekterer retfærdighed, privatliv, sikkerhed og menneskerettigheder. Du skal håndhæve disse retningslinjer på tværs af din organisation, så retfærdigheden øges i hele organisationen og afspejles i AI-systemets output.

Indstil kontroller og ansvar

Sæt klare ansvarsområder for alle i teamet, der arbejder med design, udvikling, vedligeholdelse og implementering af AI-systemet. Du skal også indstille korrekte kontroller med strenge protokoller og rammer for at imødegå skævheder, fejl og andre problemer.

Udover ovenstående skal du udføre regelmæssige revisioner for at reducere skævheder og stræbe efter løbende forbedringer. Hold dig også opdateret med de seneste ændringer i teknologi, demografi og andre faktorer.

Eksempler fra den virkelige verden på algoritmiske skævheder

#1. Amazons algoritme

Amazon er førende inden for e-handelsindustrien. Imidlertid er dens rekrutteringsværktøj der brugte AI til at vurdere jobansøgere i henhold til deres kvalifikationer, viste kønsbias. Dette AI-system blev trænet ved hjælp af CV’er fra tidligere kandidater i de tekniske roller.

Desværre havde dataene et større antal mandlige ansøgere, hvilket AI lærte. Så det favoriserede utilsigtet mandlige ansøgere i tekniske roller frem for kvinder, der var underrepræsenterede. Amazon var nødt til at afbryde værktøjet i 2017 på trods af at de gjorde en indsats for at reducere skævheden.

#2. Racistiske amerikanske sundhedsalgoritmer

En algoritme, som amerikanske hospitaler brugte til at forudsige patienter, der havde brug for yderligere pleje, var stærkt partisk over for hvide patienter. Systemet evaluerede patienternes medicinske behov baseret på deres udgiftshistorik på sundhedspleje, og korrelerede omkostninger med medicinske behov.

Systemets algoritme overvejede ikke, hvordan hvide og sorte patienter betalte for deres sundhedsbehov. På trods af ukontrolleret sygdom betalte sorte patienter for det meste for nødsituationer. De blev således kategoriseret som sundere patienter og kvalificerede sig ikke til yderligere behandling sammenlignet med hvide patienter.

#3. Googles diskriminerende algoritme

Googles onlineannoncesystem blev fundet diskriminerende. Det viste højtlønnede stillinger som administrerende direktører til mænd, der var betydeligt større end kvinder. Selvom 27 % af amerikanske administrerende direktører er kvinder, er repræsentationen for dem meget mindre i Google, omkring 11 %.

Algoritmen kunne have vist output ved at lære brugeradfærd, som at folk, der ser og klikker på annoncer for højtbetalende roller, er mænd; AI-algoritmen vil vise disse annoncer til mænd mere end kvinder.

Konklusion

Algoritmisk skævhed i ML- og AI-systemer kan føre til urimelige resultater. Disse resultater kan påvirke enkeltpersoner inden for forskellige områder, fra sundhedspleje, cybersikkerhed og e-handel til valg, beskæftigelse og mere. Det kan føre til diskrimination på grund af køn, race, demografi, seksuel orientering og andre aspekter.

Derfor er det vigtigt at reducere skævheder i AI- og ML-algoritmer for at fremme retfærdighed i resultater. Ovenstående oplysninger hjælper dig med at opdage skævheder og reducere dem, så du kan skabe retfærdige AI-systemer for brugere.

Du kan også læse om AI Governance.