For folk, der ikke er fortrolige med kodning, kan det være svært at oprette en webskraber. Heldigvis er web-skrabesoftware tilgængelig for både programmører og ikke-programmører. Web scraping software er specielt designet software til at indhente relevante data fra hjemmesider. Disse værktøjer er gavnlige for alle, der ønsker at erhverve data fra internettet på en eller anden måde. Disse oplysninger registreres i en lokal fil på computeren eller i en database. Det er teknikken til autonomt at indsamle data til nettet. Vi bringer en liste over de 31 bedste gratis webskrabeværktøjer.

Indholdsfortegnelse

31 bedste webskrabeværktøjer

En udvalgt liste over de bedste webskrabeværktøjer kan findes her. Denne liste indeholder både kommercielle og open source-værktøjer samt links til respektive websteder.

1. Overliste

Outwit er et Firefox-tilføjelsesprogram, der er nemt at installere fra Firefox-tilføjelsesbutikken.

- Dette dataskraberværktøj gør indsamling af kontakter fra nettet og via e-mail til en leg.

- Afhængigt af dine krav vil du have tre alternativer til at købe dette produkt.

- Pro

-

Ekspert, og

-

Enterprise-udgaver er tilgængelige.

- Nøjagtig data fra websteder, der bruger Outwit-hub, kræver ingen programmeringsviden.

- Du kan begynde at skrabe hundredvis af websider med et enkelt klik på udforskningsknappen.

2. PareseHub

ParseHub er endnu et af de bedste gratis webskrabeværktøjer.

- Før du downloader data, skal du rydde op i tekst og HTML.

- Det er så enkelt som at vælge de data, du vil udtrække, ved hjælp af vores sofistikerede webskraber.

- Det er et af de bedste dataskrabeværktøjer, da det giver dig mulighed for at gemme skrabet data i ethvert format til yderligere analyse.

- Den brugervenlige grafiske grænseflade

- Dette internet-skrabeværktøj giver dig mulighed for automatisk at høste og gemme data på servere.

3. Apify

Apify er endnu et af de bedste webskrabnings- og automatiseringsværktøjer, der lader dig konstruere en API til ethvert websted med indbyggede bolig- og datacenterproxyer, der gør dataudtræk lettere.

- Apify tager sig af infrastruktur og fakturering, hvilket giver udviklere mulighed for at tjene passive penge ved at designe værktøjer til andre.

- Nogle af de tilgængelige stik er Zapier, Integromat, Keboola og Airbyte.

- Apify Store har færdige skrabeløsninger til populære websteder som Instagram, Facebook, Twitter og Google Maps.

- JSON, XML, CSV, HTML og Excel er alle strukturerede formularer, der kan downloades.

- HTTPS, geolocation-målretning, smart IP-rotation og Google SERP-proxyer er alle funktioner i Apify Proxy.

- Gratis 30-dages proxy-prøveperiode med en platformkredit på 5 USD.

4. Skrabestack

Scrapestack bruges af over 2.000 firmaer, og de er afhængige af denne unikke API, som er drevet af apilayer. Det er et af de bedste gratis webskrabeværktøjer.

- Bruger en verdensomspændende IP-adressepulje på 35 millioner datacentre.

- Tillader, at mange API-anmodninger udføres på én gang.

- Både CAPTCHA-dekryptering og JavaScript-gengivelse understøttes.

- Der er både gratis og betalte muligheder.

- Scrapestack er en online scraping REST API, der fungerer i realtid.

- Scrapestack API’en giver dig mulighed for at skrabe websider på millisekunder ved hjælp af millioner af proxy-IP’er, browsere og CAPTCHA’er.

- Web-skrabeanmodninger kan sendes fra mere end 100 forskellige steder i hele verden.

5. FMiner

Til Windows og Mac OS er FMiner et populært online-skrabning, dataudtræk, crawling screen scraping, makro og web-supportprogram.

- Data kan indsamles fra dynamiske Web 2.0-websteder, der er svære at crawle.

- Giver dig mulighed for at oprette et dataudtræksprojekt ved hjælp af den visuelle editor, som er enkel at bruge.

- Bruger en kombination af linkstrukturer, rullemenuer og URL-mønstermatchning for at lade dig grave ned gennem websider.

- Du kan bruge tredjeparts automatiske decaptcha-tjenester eller manuel input til at målrette webstedets CAPTCHA-beskyttelse.

6. Sequentum

Sequentum er et robust big data-værktøj til at opnå troværdige onlinedata. Det er endnu et af de bedste gratis webskrabeværktøjer.

- I sammenligning med alternative løsninger bliver det hurtigere at udtrække onlinedata.

- Du kan skifte mellem flere platforme ved hjælp af denne funktion.

- Det er en af de mest kraftfulde webskrabere til vækst af din virksomhed. Den indeholder enkle funktioner, herunder en visuel peg-og-klik-editor.

- Den dedikerede web-API vil hjælpe dig med at udvikle webapps ved at give dig mulighed for at eksekvere webdata direkte fra dit websted.

7. Agentur

Agenty er et dataskrabning, tekstudtræk og OCR-program, der bruger Robotic Process Automation.

- Dette program giver dig mulighed for at genbruge alle dine behandlede data til analyseformål.

- Du kan bygge en agent med kun et par museklik.

- Du vil modtage en e-mail, når din opgave er afsluttet.

- Det giver dig mulighed for at oprette forbindelse til Dropbox og bruge sikker FTP.

- Alle aktivitetslogfiler for alle hændelser er tilgængelige for at se.

- Hjælper dig med at forbedre din virksomheds succes.

- Giver dig mulighed for nemt at implementere forretningsregler og tilpasset logik.

8. Import.io

Ved at importere data fra en bestemt webside og eksportere dataene til CSV, hjælper import.io web scraping-applikationen dig med at danne dine datasæt. Det er også et af de bedste webskrabeværktøjer. Følgende er funktionerne i dette værktøj.

- Webformularer/login er enkle at bruge.

- Det er en af de bedste dataskrabeløsninger til at udnytte API’er og webhooks til at integrere data i apps.

- Du kan få indsigt via rapporter, diagrammer og visualiseringer.

- Dataudtræk bør planlægges på forhånd.

- Import.io cloud giver dig mulighed for at gemme og få adgang til data.

- Interaktion med nettet og arbejdsgange kan automatiseres.

9. Webz.io

Webz.io giver dig mulighed for at crawle hundredvis af websteder og få adgang til strukturerede og realtidsdata med det samme. Det er også et af de bedste gratis webskrabeværktøjer.

Du kan erhverve organiserede, maskinlæsbare datasæt i JSON- og XML-formater.

- Det giver dig adgang til historiske feeds, der strækker sig over ti års data.

- Giver dig adgang til en stor database med datafeeds uden at skulle betale yderligere udgifter.

- Du kan bruge et avanceret filter til at lave detaljerede analyser og feed-datasæt.

10. Skrabeugle

Scrape Owl er en webskrabeplatform, der er nem at bruge og økonomisk.

- Scrape Owls primære mål er at skrabe enhver form for data, herunder e-handel, jobtavler og ejendomsannoncer.

- Før du udtrækker materialet, kan du køre tilpasset JavaScript.

- Du kan bruge lokationer til at omgå lokale begrænsninger og få adgang til lokalt indhold.

- Giver en pålidelig ventefunktion.

- Helsides JavaScript-gengivelse er understøttet.

- Denne applikation kan bruges direkte på et Google Sheet.

- Tilbyder en gratis prøveperiode på 1000 kredit for at prøve tjenesten, før du køber et medlemskab. Der er ingen grund til at bruge et kreditkort.

11. Skrabebi

Scrapingbee er en web-scraping API, der tager sig af proxy-indstillinger og hovedløse browsere.

- Det kan udføre Javascript på siderne og rotere proxyer for hver anmodning, så du kan læse den rå HTML uden at blive sortlistet.

- En anden API til at udtrække Google-søgeresultater er også tilgængelig.

- JavaScript-gengivelse er understøttet.

- Den har en automatisk proxy-rotationsfunktion.

- Denne applikation kan bruges direkte på Google Sheets.

- Chrome-webbrowseren er påkrævet for at bruge programmet.

- Den er ideel til Amazon-skrabning.

- Det giver dig mulighed for at skrabe Google-resultater.

12. Lyse data

Bright Data er verdens førende online dataplatform, der tilbyder en omkostningseffektiv løsning til at indsamle offentlige webdata i stor skala, konvertere ustrukturerede data til strukturerede data med lethed og give en overlegen kundeoplevelse, samtidig med at den er fuldstændig gennemsigtig og kompatibel.

- Det er det mest tilpasningsdygtige, da det kommer med præfabrikerede løsninger og kan udvides og justeres.

- Bright Datas næste generations Data Collector giver et automatiseret og personligt flow af data på et enkelt dashboard, uanset størrelsen af samlingen.

- Det er åbent 24 timer i døgnet, syv dage om ugen og tilbyder kundeassistance.

- Fra e-handelstrends og sociale netværksdata til konkurrentintelligens og markedsundersøgelser, datasæt er skræddersyet til din virksomheds behov.

- Du kan koncentrere dig om din primære virksomhed ved at automatisere adgangen til pålidelige data i din branche.

- Det er det mest effektive, da det bruger kodeløse løsninger og bruger færre ressourcer.

- Mest pålidelige med data af den bedste kvalitet, højere oppetid, hurtigere data og bedre kundeservice.

13. Scraper API

Du kan bruge Scraper API-værktøjet til at håndtere proxyer, browsere og CAPTCHA’er.

- Værktøjet giver uovertruffen hastighed og pålidelighed, hvilket giver mulighed for at skabe skalerbare webskrabere.

- Du kan få HTML’en fra enhver webside med et enkelt API-kald.

- Det er nemt at konfigurere, da alt du skal gøre er at sende en GET-anmodning med din API-nøgle og URL til API-endepunktet.

- Tillader, at JavaScript gengives nemmere.

- Det giver dig mulighed for at tilpasse anmodningstypen og overskrifterne for hver anmodning.

- Roterende fuldmagter med en geografisk placering

14. Dexi Intelligent

Dexi intelligent er en online-skrabeapplikation, der giver dig mulighed for at omdanne enhver mængde webdata til hurtig kommerciel værdi.

- Dette online skrabeværktøj giver dig mulighed for at spare penge og tid for din virksomhed.

- Det har forbedret produktivitet, nøjagtighed og kvalitet.

- Det muliggør den hurtigste og mest effektive dataudtræk.

- Det har et storstilet videnfangstsystem.

15. Diffbot

Diffbot giver dig mulighed for hurtigt at få en række vigtige fakta fra internettet.

- Med AI-udtrækkere vil du være i stand til at udtrække nøjagtige strukturerede data fra enhver URL.

- Du vil ikke blive opkrævet for tidskrævende skrabning af hjemmeside eller manuel forespørgsel.

- For at opbygge et fuldstændigt og præcist billede af hvert objekt er mange datakilder flettet sammen.

- Du kan udtrække strukturerede data fra enhver URL med AI Extractors.

- Med Crawlbot kan du skalere din udvinding op til titusindvis af domæner.

- Funktionen Knowledge Graph giver nettet nøjagtige, fulde og dybe data, som BI har brug for for at levere meningsfuld indsigt.

16. Datastreamer

Data Streamer er en teknologi, der giver dig mulighed for at få socialt netværksmateriale fra hele internettet.

- Det er en af de største online skrabere, der bruger naturlig sprogbehandling til at hente vigtige metadata.

-

Kibana og Elasticsearch bruges til at give integreret fuldtekstsøgning.

- Baseret på informationshentningsalgoritmer, integreret fjernelse af kedelplader og indholdsudtræk.

- Bygget på en fejltolerant infrastruktur for at give høj informationstilgængelighed.

17. Mozenda

Du kan udtrække tekst, fotos og PDF-materiale fra websider ved hjælp af Mozenda.

- Du kan bruge dit valg Bl værktøj eller database til at indsamle og publicere online data.

- Det er et af de bedste online-skrabeværktøjer til at organisere og formatere datafiler til udgivelse.

- Med en peg-og-klik-grænseflade kan du oprette web-skrabemidler på få minutter.

- For at indsamle webdata i realtid skal du bruge funktionerne Job Sequencer og Request Blocking.

- Account management og kundeservice er blandt de bedste i branchen.

18. Data Miner Chrome-udvidelse

Webskrabning og datafangst gøres nemmere med Data Miner browser plugin.

- Det har evnen til at crawle flere sider samt dynamisk dataudtræk.

- Dataudvælgelse kan udføres på en række forskellige måder.

- Det undersøger de oplysninger, der er blevet skrabet.

- It Data skrabet kan gemmes som en CSV-fil.

- Lokal lagring bruges til at gemme skrabet data.

- Chrome-tilføjelsen Web Scraper trækker data fra dynamiske websteder.

- it Sitemaps kan importeres og eksporteres.

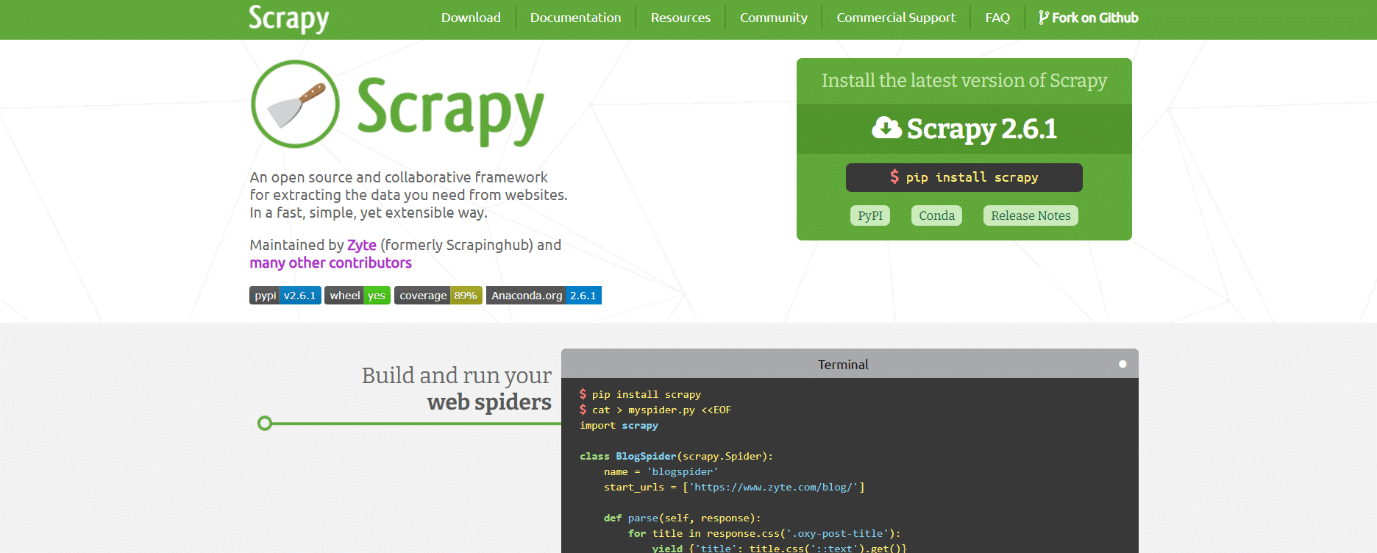

19. Scrapy

Scrapy er også et af de bedste webskrabeværktøjer. Det er en Python-baseret open source online skraberamme til at skabe webskrabere.

- Det giver dig alle de værktøjer, du skal bruge for hurtigt at udtrække data fra websteder, analysere dem og gemme dem i den struktur og det format, du vælger.

- Dette dataskrabeværktøj er et must-have, hvis du har et stort dataskrabeprojekt og ønsker at gøre det så effektivt som muligt og samtidig bevare en masse fleksibilitet.

- Dataene kan eksporteres som JSON, CSV eller XML.

- Linux, Mac OS X og Windows er alle understøttet.

- Den er udviklet oven på Twisted asynkron netværksteknologi, som er en af dens nøglefunktioner.

- Scrapy er bemærkelsesværdig for sin enkelhed i brug, omfattende dokumentation og aktive fællesskab.

20. ScrapeHero Cloud

ScrapeHero har taget sin årelange viden om webcrawling og forvandlet den til økonomiske og brugervenlige forudbyggede crawlere og API’er til at skrabe data fra websteder som Amazon, Google, Walmart og andre.

- ScrapeHero Cloud-crawlere inkluderer automatisk roterende proxyer og mulighed for at køre mange crawlere på samme tid.

- Du behøver ikke at downloade eller lære, hvordan du bruger dataskrabeværktøjer eller software for at bruge ScrapeHero Cloud.

- ScrapeHero Cloud-crawlere giver dig mulighed for øjeblikkeligt at skrabe data og eksportere dem i JSON-, CSV- eller Excel-formater.

- ScrapeHero Clouds gratis- og Lite-planklienter modtager e-mail-hjælp, mens alle andre planer modtager Priority-service.

- ScrapeHero Cloud-crawlere kan også konfigureres til at opfylde specifikke kundekrav.

- Det er en browserbaseret webskraber, der fungerer med enhver webbrowser.

- Du behøver ikke nogen programmeringsviden eller for at udvikle en skraber; det er lige så nemt som at klikke, kopiere og indsætte!

21. Dataskraber

Data Scraper er et gratis online-skrabeprogram, der skraber data fra en enkelt webside og gemmer dem som CSV- eller XSL-filer.

- Det er en browserudvidelse, der konverterer data til et pænt tabelformat.

- Installation af pluginnet kræver brug af Google Chrome-browseren.

- Du kan skrabe 500 sider hver måned med den gratis version; men hvis du ønsker at skrabe flere sider, skal du opgradere til en af de dyre planer.

22. Visual Web Ripper

Visual Web Ripper er et automatisk dataskrabeværktøj til websteder.

- Datastrukturer indsamles fra websteder eller søgeresultater ved hjælp af dette værktøj.

- Du kan eksportere data til CSV-, XML- og Excel-filer, og det har en brugervenlig grænseflade.

- Det kan også høste data fra dynamiske websteder, såsom dem, der bruger AJAX.

- Du skal blot opsætte et par skabeloner, så klarer webskraberen resten.

- Visual Web Ripper tilbyder planlægningsmuligheder og sender dig endda en e-mail, hvis et projekt mislykkes.

23. Octoparse

Octoparse er en brugervenlig webside-skrabeapplikation med en visuel grænseflade. Det er et af de bedste gratis webskrabeværktøjer. Følgende er funktionerne i dette værktøj.

- Dens peg-og-klik-grænseflade gør det nemt at vælge de oplysninger, du ønsker at skrabe fra et websted. Octoparse kan håndtere både statiske og dynamiske websider takket være AJAX, JavaScript, cookies og andre muligheder.

- Avancerede cloud-tjenester, der giver dig mulighed for at udtrække store mængder data, er nu tilgængelige.

- De skrabede oplysninger kan gemmes som TXT-, CSV-, HTML- eller XLSX-filer.

- Den gratis version af Octoparse giver dig mulighed for at konstruere op til 10 crawlere; dog inkluderer betalte medlemskabsplaner funktioner såsom en API og et stort antal anonyme IP-proxyer, som vil fremskynde din udtrækning og give dig mulighed for at downloade store mængder data i realtid.

24. Web Harvey

WebHarveys visuelle webskraber har en indbygget browser til at skrabe data fra onlinesider. Det er også et af de bedste webskrabeværktøjer. Her er et par funktioner i dette værktøj.

- Det tilbyder en peg-og-klik-grænseflade, der gør det nemt at vælge varer.

- Denne skraber har den fordel, at den ikke kræver, at du skriver nogen kode.

-

CSV-, JSON- og XML-filer kan bruges til at gemme dataene.

- Det er også muligt at gemme det i en SQL-database. WebHarvey har en kategoriskrapningsfunktion på flere niveauer, der kan skrabe data fra listesider ved at følge hvert niveau af kategoriforbindelser.

- Regulære udtryk kan bruges sammen med internet-skrabeværktøjet, hvilket giver dig yderligere frihed.

- Du kan konfigurere proxyservere til at holde din IP skjult, mens du trækker data fra websteder, så du kan bevare en vis grad af privatliv.

25. PySpider

PySpider er også et af de bedste gratis webskrabeværktøjer, som er en Python-baseret webcrawler. Et par funktioner i dette værktøj er angivet nedenfor.

- Den har en distribueret arkitektur og understøtter Javascript-sider.

- Du kan have mange crawlere på denne måde. PySpider kan gemme data på enhver backend, du vælger, inklusive MongoDB, MySQL, Redis og andre.

- Beskedkøer såsom RabbitMQ, Beanstalk og Redis er tilgængelige.

- En af PySpiders fordele er dens enkle brugergrænseflade, som giver dig mulighed for at ændre scripts, overvåge kørende aktiviteter og undersøge resultater.

- Oplysningerne kan downloades i JSON- og CSV-formater.

- PySpider er den internetskrabe, du skal overveje, hvis du arbejder med en webstedsbaseret brugergrænseflade.

- Det fungerer også med websteder, der bruger meget AJAX.

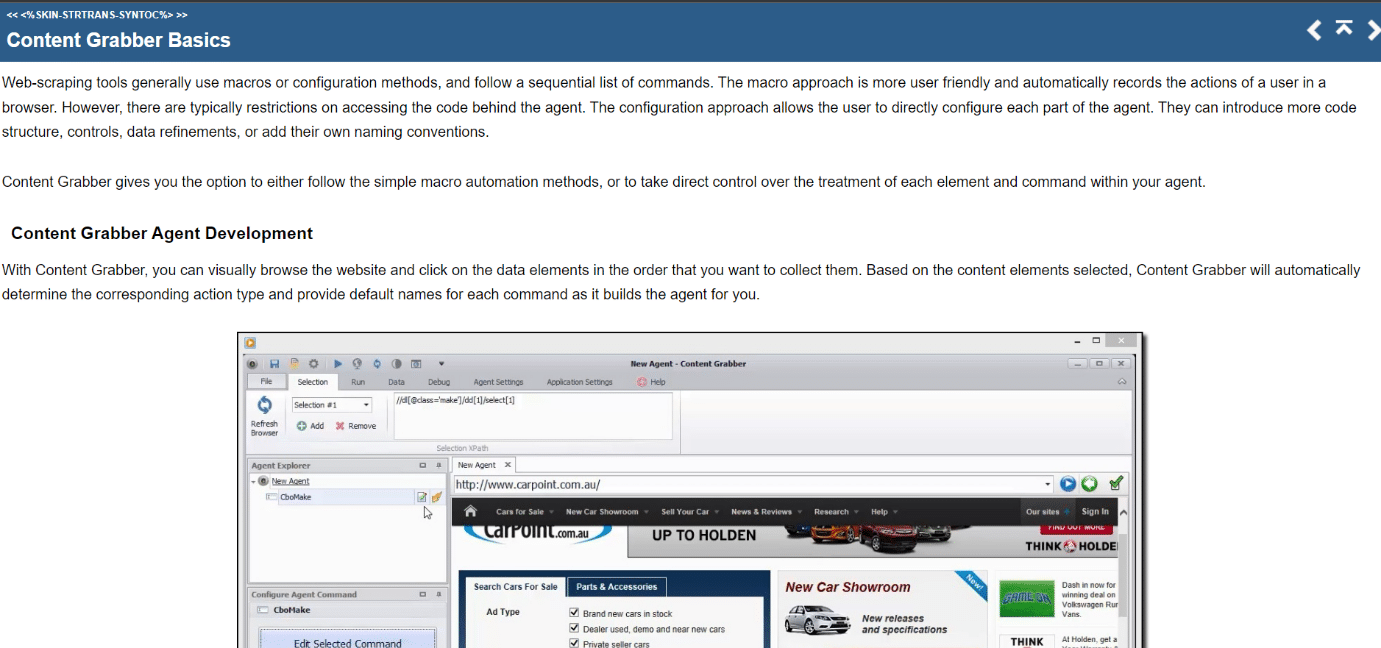

26. Indholdsgrabber

Content Grabber er et visuelt online skrabeværktøj med en letanvendelig peg-og-klik-grænseflade til at vælge elementer. Følgende er funktionerne i dette værktøj.

- CSV, XLSX, JSON og PDF er de formater, som data kan eksporteres i. Der kræves mellemliggende programmeringsfærdigheder for at bruge dette værktøj.

- Sideinddeling, ubegrænsede rullesider og pop-ups er alle mulige med dens brugergrænseflade.

- Den har også AJAX/Javascript-behandling, en captcha-løsning, support til regulære udtryk og IP-rotation (ved hjælp af Nohodo).

27. Kimurai

Kimurai er en Ruby web-skraberamme til at skabe skrabere og udvinde data. Det er også et af de bedste gratis webskrabeværktøjer. Her er et par funktioner i dette værktøj.

- Det giver os mulighed for at skrabe og interagere med JavaScript-producerede websider lige ud af boksen med Headless Chromium/Firefox, PhantomJS eller grundlæggende HTTP-forespørgsler.

- Det har en lignende syntaks som Scrapy og konfigurerbare muligheder, herunder indstilling af en forsinkelse, roterende brugeragenter og standardoverskrifter.

- Det interagerer også med websider ved hjælp af Capybara-testrammerne.

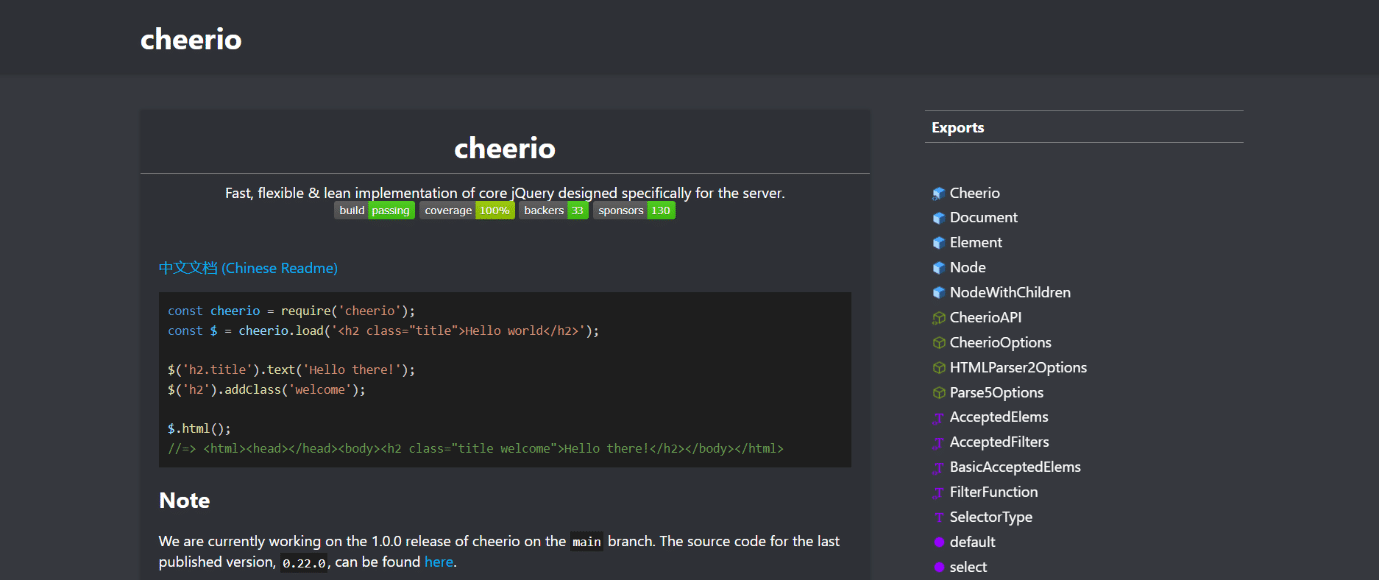

28. Cheerio

Cheerio er endnu et af de bedste webskrabeværktøjer. Det er en pakke, der analyserer HTML- og XML-dokumenter og giver dig mulighed for at arbejde med de downloadede data ved hjælp af jQuery-syntaksen. Følgende er funktionerne i dette værktøj.

- Hvis du udvikler en JavaScript-webskraber, giver Cheerio API et hurtigt valg til at analysere, ændre og vise data.

- Det gengiver ikke output i en webbrowser, anvender CSS, indlæser eksterne ressourcer eller kører JavaScript.

- Hvis nogen af disse funktioner er påkrævet, bør du se på PhantomJS eller JSDom.

29. Dukkefører

Puppeteer er en Node-pakke, der giver dig mulighed for at administrere Googles hovedløse Chrome-browser ved hjælp af en kraftfuld, men simpel API. Et par funktioner i dette værktøj er angivet nedenfor.

- Den kører i baggrunden og udfører kommandoer gennem en API.

- En hovedløs browser er en, der er i stand til at sende og modtage anmodninger, men som mangler en grafisk brugergrænseflade.

- Puppeteer er den rigtige løsning til opgaven, hvis den information, du leder efter, er genereret ved hjælp af en kombination af API-data og Javascript-kode.

- Du kan efterligne brugerens oplevelse ved at skrive og klikke de samme steder, som de gør.

- Puppeteer kan også bruges til at tage skærmbilleder af websider, der vises som standard, når en webbrowser åbnes.

30. Dramatiker

Playwright er et Microsoft Node-bibliotek designet til browserautomatisering. Det er endnu et af de bedste gratis webskrabeværktøjer. Her er et par funktioner i dette værktøj.

- Det tilbyder kompetent, pålidelig og hurtig webautomatisering på tværs af browsere.

- Playwright var beregnet til at forbedre automatiseret UI-test ved at fjerne flak, øge udførelseshastigheden og give indsigt i, hvordan browseren fungerer.

- Det er en moderne browserautomatiseringsapplikation, der på mange måder kan sammenlignes med Puppeteer og leveres med forudinstallerede kompatible browsere.

- Dens største fordel er kompatibilitet på tværs af browsere, da den kan køre Chromium, WebKit og Firefox.

- Playwright integrerer med Docker, Azure, Travis CI og AppVeyor regelmæssigt.

31. PJScrape

PJscrape er et Python-baseret online-skrabeværktøj, der bruger Javascript og JQuery. Følgende er funktionerne i dette værktøj.

- Det er designet til at fungere med PhantomJS, så du kan skrabe websteder fra kommandolinjen i en fuldt gengivet, Javascript-aktiveret kontekst uden behov for en browser.

- Dette indebærer, at du ikke kun kan få adgang til DOM, men også Javascript-variabler og -funktioner samt AJAX-indlæst indhold.

- Skraberfunktionerne vurderes i sammenhæng med hele browseren.

***

Vi håber, at denne vejledning var nyttig om de bedste webskrabeværktøjer. Fortæl os, hvilket værktøj du finder nemt for dig. Fortsæt med at besøge vores side for flere fede tips og tricks, og efterlad dine kommentarer nedenfor.